Velké jazykové modely: Skok vpřed nebo slepá ulička v AI?

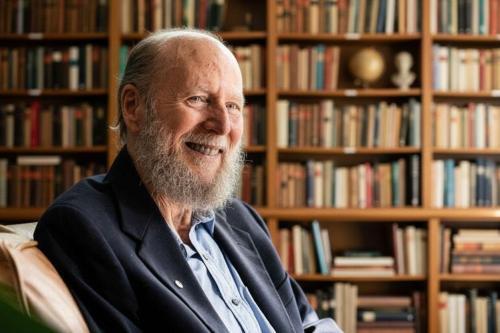

V oblasti umělé inteligence probíhá intenzivní diskuse, která zpochybňuje základy současných generativních systémů. Na jedné straně stojí úspěchy velkých jazykových modelů (LLM), jako je ChatGPT, které mnozí považují za obrovský pokrok. Na druhé straně se ozývá hlasy, jako je ten od držitele Turingovy ceny Richarda Suttona, který tyto modely označuje za sofistikovanou formu napodobování, která nikdy nedosáhne skutečné inteligence. Tento pohled vychází z jeho rozhovoru s Dwarkeshem Patelem, kde Sutton vysvětluje, proč modely trénované na předpovídání slov selžou v budování opravdového porozumění světu.

Richard Sutton a jeho kritika LLM

Richard Sutton, známý jako otec učení posilováním a autor eseje The Bitter Lesson, v rozhovoru s Dwarkeshem Patelem tvrdí, že velké jazykové modely jsou mistrovskými napodobiteli, ale ne stavějí skutečné modely světa. Tyto systémy se učí předpovídat, co by člověk řekl, ne co se ve skutečnosti děje. Například model jako ChatGPT se trénuje na obrovském množství textu z internetu, což mu umožňuje generovat odpovědi, které znějí lidsky, ale chybí jim přímá interakce se světem. Sutton zdůrazňuje, že bez cílů a přímé zkušenosti z akcí a jejich důsledků nelze dosáhnout inteligence. Podle něj inteligence spočívá v dosahování cílů ve světě, a předpovídání dalšího slova není takovým cílem, protože neovlivňuje vnější realitu.

Sutton přirovnává situaci k učení dětí nebo zvířat. Děti se neučí napodobováním od narození, ale prostřednictvím pokusů a omylů. Například dítě máchá rukama a slyší zvuky, které samo vytváří, a tak se učí z důsledků svých akcí. Stejně tak veverka se neučí skákat mezi větvemi tím, že sleduje dokonalý příklad, ale z vlastních pokusů, kde úspěch nebo pád poskytuje zpětnou vazbu. Velké jazykové modely toto postrádají – nemají tělo, nemají přímou zkušenost a nemohou být "překvapeny" výsledky, které by je donutily upravit své znalosti.

Alternativní možnosti

Místo velkých jazykových modelů navrhuje Sutton agenta složeného ze čtyř částí, který se učí nepřetržitě z proudu senzorických vjemů, akcí a odměn. První část je politika, která rozhoduje o akcích v dané situaci. Druhá je funkce hodnoty, která předpovídá dlouhodobé výsledky, což pomáhá řešit problémy s řídkými odměnami, jako je úspěch startupu po deseti letech. Třetí je vnímání, které vytváří reprezentaci aktuálního stavu. Čtvrtá je přechodový model, který předpovídá důsledky akcí, jako interní "fyzikální motor" agenta.

Tento agent by se neučil v oddělené fázi tréninku, ale neustále z vlastních zkušeností. Nové znalosti by se integrovály přímo do vah sítě, což by umožnilo adaptaci na jedinečné prostředí. Sutton věří, že takový přístup vede k robustnější inteligenci, protože se zakládá na přímých důsledcích, podobně jako u programu TD-Gammon z 90. let, který se naučil hrát backgammon prostřednictvím učení posilováním.

Hypotéza velkého světa a OaK architektura

Suttonova myšlenka vychází z hypotézy velkého světa, kde je realita příliš složitá na to, aby ji bylo možné zachytit v jednom statickém datovém souboru. Proto musí agent učit se za běhu, na základě svých jedinečných zkušeností, jako je poznávání jména kolegy nebo dynamiky nového projektu. V tom vidí omezení velkých jazykových modelů, které se spoléhají na předtrénované znalosti z designové fáze.

Sutton představuje architekturu OaK (Options and Knowledge - Možnosti a vědění), která vytváří cyklus objevování. Agent identifikuje zajímavé rysy v datech, proměňuje je v podproblémy, učí se možnosti (politiky) k jejich řešení, buduje modely těchto možností a plánuje na základě nich. Tento cyklus umožňuje agentovi vytvářet vlastní abstrakce bez lidského dohledu, podobně jako dítě objevuje svět hrou. Sutton přiznává, že zůstávají výzvy, jako spolehlivé nepřetržité hluboké učení a automatické učení reprezentací, ale vidí v tom cestu k superinteligenci.

Protiargumenty obhájců velkých jazykových modelů

Z pohledu zastánců velkých jazykových modelů není napodobování chybou, ale základem. Tyto modely se učí předpovídat text na obrovském měřítku, což je nutí budovat interní reprezentace světa – například fyziky nebo logiky programování. Řetězové myšlení umožňuje modelům opravovat chyby krok za krokem, což naznačuje skutečný model, ne jen vzory.

Předpovídání dalšího tokenu je podle nich nejobecnější cíl pro předtrénink, který poskytuje znalosti pro další učení posilováním z lidské zpětné vazby. Problémy s nepřetržitým učením jsou technické, řešitelné technikami jako retrieval-augmented generation (generování s načítáním), které umožňují přístup k novým informacím bez úplného přetrénování. Velké jazykové modely tak řeší problém "studeného startu" pro agenty učení posilováním, poskytujíce jim bohatý základ znalostí.

Závěr myšlenky

Sutton vidí v učení posilováním budoucnost, kde agenti s vlastními cíli překonají napodobování. Věří, že nástupství AI je nevyhnutelné, protože nejinteligentnější entity získají moc. Naopak, absence cílů v velkých jazykových modelech by mohla být bezpečnostní výhodou, činící je nástroji pod kontrolou. Tato debata ovlivní, kam poplynou investice v miliardách, a zda budeme budovat systémy, které svět opravdu chápou, nebo jen odrážejí naše slova. Je pravděpodobné, že velké jazykové modely budou součástí cesty k umělé obecné inteligenci, ale ne jejím konečným tvarem.

Zdroj: theneuron.ai