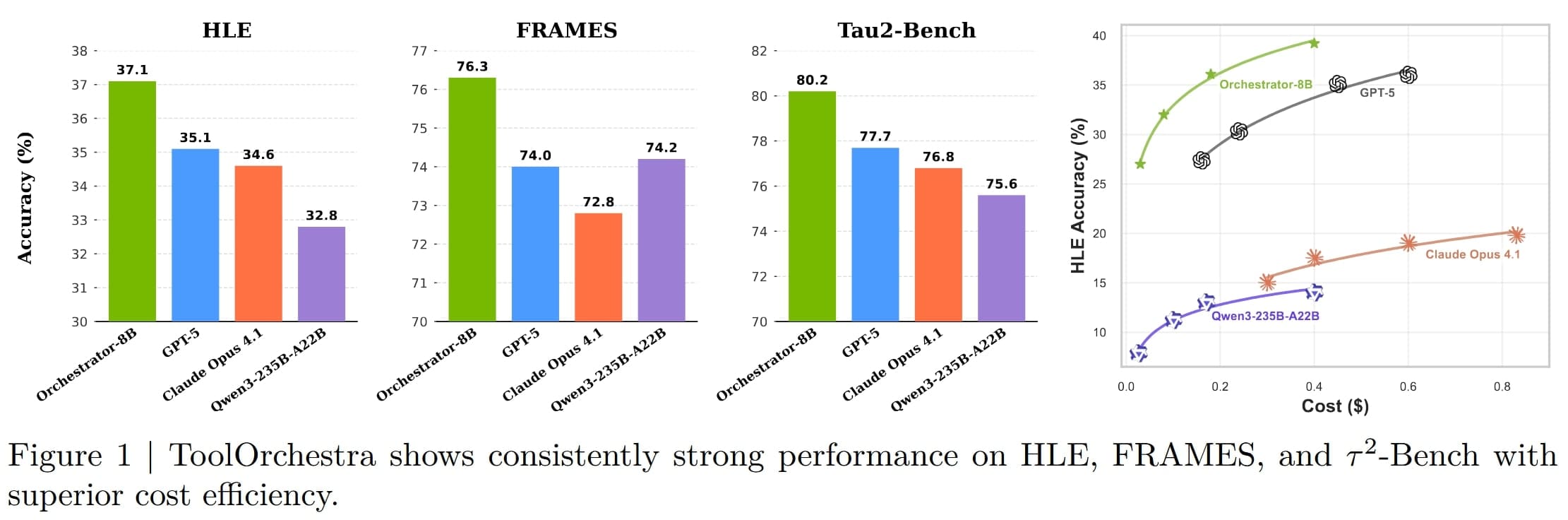

Představte si malý model s 8 miliardami parametrů, který se jmenuje Orchestrator a funguje jako dirigent v orchestru plném nástrojů a chytrých modelů. Tento kousek od výzkumníků od Nvidie a University of Hong Kong řeší složité úlohy, jako ty z Humanity's Last Exam (HLE), kde dosáhl skóre 37,1 %, zatímco GPT-5 jen 35,1 %. A to všechno při 2,5násobné úspoře nákladů! Žádný obří model, jen chytrá koordinace.

Proč jsou malé modely výkonější než velké?

Orchestrator není žádný osamělý hrdina – volá si na pomoc nástroje jako Tavily search API pro webové vyhledávání, Python sandbox pro spouštění kódu nebo specializované modely jako Qwen2.5-Math-72B pro matematiku. V tréninku používá posilování učení s odměnami za správný výsledek, nízké náklady a dodržení uživatelských preferencí. Například na benchmarku FRAMES překonal GPT-5 s 76,3 % úspěšností při pouhých 30 % nákladů.

V každém kole Orchestrator přemýšlí, vybere nástroj – třeba GPT-5-mini pro kódování nebo Llama-3.3-70B-Instruct pro obecnější úkoly – a pak zpracuje odpověď. Výzkumníci vytvořili dataset ToolScale s tisíci příklady z oblastí jako finance, sport nebo medicína, kde model učí koordinovat až 50 kol interakcí. Výsledek? Na τ²-Bench dosáhl 80,2 %, přičemž volal GPT-5 jen ve 40 % případů, a přesto byl lepší než samotný GPT-5.

Přizpůsobení pro každého

Uživatelé si mohou nastavit preference – například upřednostnit lokální vyhledávání před internetovým kvůli soukromí. Orchestrator se tomu přizpůsobí, což ho dělá flexibilním i pro neznámé nástroje jako Claude Opus 4.1 nebo DeepSeekMath-7b-Instruct. Celý systém je navržený tak, aby byl rychlý a levný s latencí v minutách a náklady v centech. Podrobnou zprávu si můžete přečíst na arxiv.org.