Jeden rok s Phi: Revoluce malých jazykových modelů v praxi

V dynamickém světě umělé inteligence často dominují gigantické jazykové modely s desítkami či stovkami miliard parametrů, které spotřebovávají enormní výpočetní zdroje. Avšak poslední rok přinesl pozoruhodný obrat - série malých jazykových modelů (SLM) od Microsoftu pod označením Phi dokázala, že i podstatně menší modely mohou dosahovat vynikajících výsledků při zlomku nákladů. Tento přístup může zásadně změnit způsob, jakým organizace implementují a využívají generativní umělou inteligenci.

Od vize k realitě: Roční cesta modelů Phi

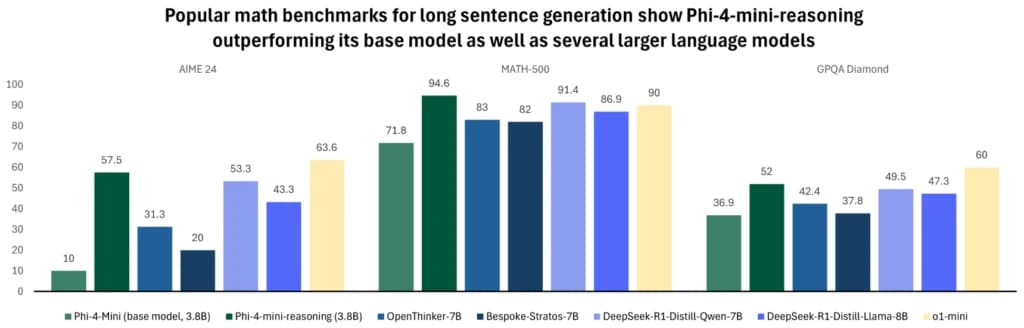

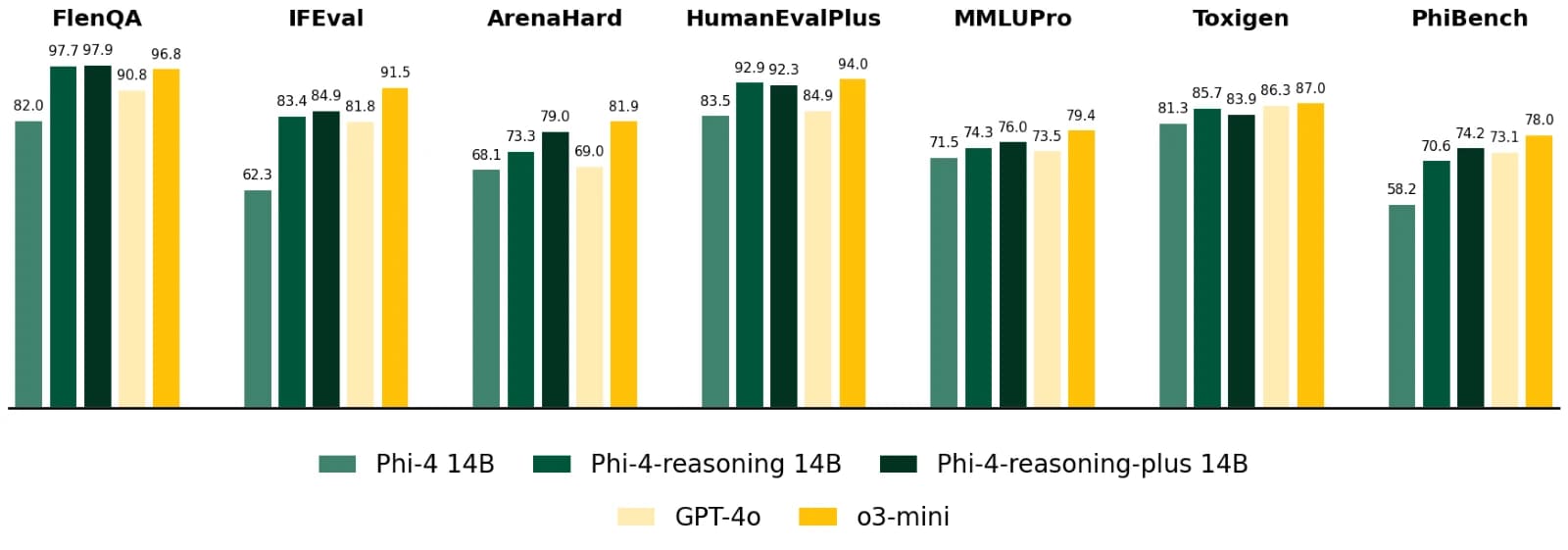

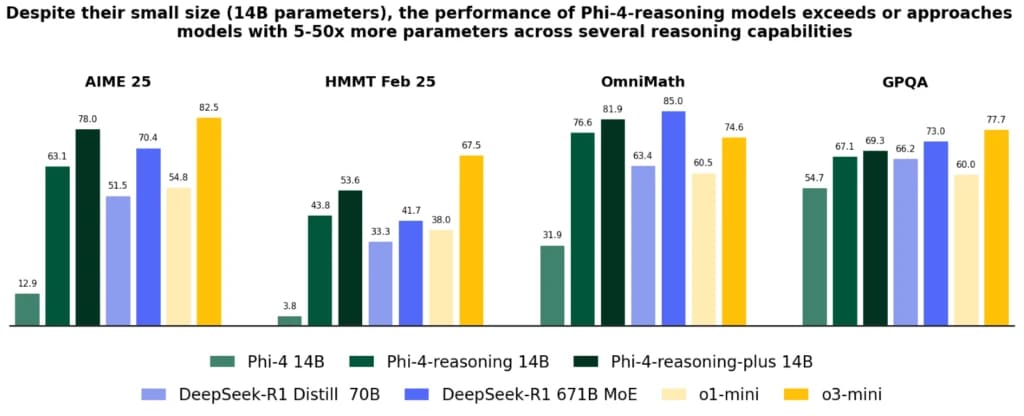

Když Microsoft před rokem představil první model Phi-1, málokdo předpokládal, jak rychle se tato technologie vyvine. Za pouhý rok se rodina Phi rozrostla o několik generací, přičemž každá přinesla významná vylepšení. Phi-3, vydaný v prvním čtvrtletí 2025, nabídl varianty mini, small a medium s 3,8 až 14 miliardami parametrů. Nejnovější přírůstky - Phi-4-reasoning, Phi-4-reasoning-plus a Phi-4-mini-reasoning - posouvají hranice vícekrokového uvažování a řešení složitých problémů. Tyto modely představují významný průlom v oblasti efektivity AI. Jak uvádí technická zpráva z arXiv, výzkumníci Microsoftu využili pokročilé techniky jako "scaled up inference" a distilaci znalostí z větších modelů, aby dosáhli maximálního výkonu s minimálními zdroji. Například model Phi-4-reasoning s pouhými 14 miliardami parametrů dokáže v některých matematických benchmarcích překonat mnohem větší modely, včetně těch s více než 600 miliardami parametrů.

Technické inovace stojící za úspěchem

Za působivými výsledky modelů Phi stojí několik klíčových inovací:

- Optimalizovaný tréninkový proces

Výzkumníci Microsoftu se zaměřili na kvalitu nad kvantitou. Místo trénování na obrovských, nefiltrovaných korpusech textu používají pečlivě kurátorovaná data. Tento přístup označují jako "high-quality data curation" a umožňuje modelům získat hlubší pochopení konceptů při menším množství dat. - Vícestupňové uvažování

Nejnovější modely Phi, zejména Phi-4-reasoning, jsou optimalizovány pro úlohy vyžadující složité, vícekrokové uvažování. Podle technické zprávy byl model trénován specificky na úlohách vyžadujících rozložení problému na dílčí kroky, což je klíčové pro matematické úlohy nebo logické hádanky. - Škálování při inferenci

Zajímavou technikou popsanou v dokumentaci je "scaled up inference", kdy model při generování odpovědí může věnovat více výpočetních zdrojů složitějším problémům, zatímco jednodušší úlohy řeší efektivněji. Tato adaptabilita dále zvyšuje efektivitu modelů v reálném nasazení.

Měřitelné výsledky: Jak si Phi vede v praxi

Výsledky testů jsou pozoruhodné. V benchmarku AIME 2025 (American Invitational Mathematics Examination) dosáhl Phi-4-reasoning-plus lepších výsledků než model DeepSeek-R1 s 671 miliardami parametrů. V dalších testech, jako je GSM8K pro matematické uvažování, se malé modely Phi vyrovnaly nebo překonaly mnohem větší konkurenty. Konkrétní výsledky z technické zprávy ukazují, že Phi-3-medium (14B) dosahuje skóre 74.6% na GSM8K matematickém benchmarku, což překonává mnoho větších modelů a blíží se výsledkům modelů s 5-10× více parametry.

Praktické výhody: Proč jsou malé modely velkou příležitostí

- Rychlost a efektivita

Menší modely generují odpovědi výrazně rychleji a s nižšími výpočetními nároky. Pro aplikace vyžadující real-time interakci je tento aspekt klíčový - uživatelé nemusí čekat na odpověď, což zlepšuje uživatelský zážitek. - Flexibilita nasazení

Díky kompaktní velikosti lze modely Phi provozovat na širokém spektru zařízení - od cloudových serverů až po edge zařízení s omezenými zdroji. To otevírá možnosti pro nasazení AI v prostředích s omezenou konektivitou nebo vysokými požadavky na latenci. - Přizpůsobitelnost

Menší modely lze snáze a levněji doladit pro specifické domény nebo podnikové potřeby. Jak uvádí Azure blog, organizace mohou vzít předtrénovaný model Phi a s relativně malým množstvím doménově specifických dat ho adaptovat na své konkrétní úlohy. - Dostupnost a demokratizace AI

Nižší náklady na trénování, nasazení a provoz znamenají, že pokročilé AI technologie jsou dostupnější i pro menší organizace a vývojáře s omezenými rozpočty. Jak Microsoft zdůrazňuje ve svém blogu, jde o součást širšího úsilí o demokratizaci AI technologií.

Nový přístup k nasazení AI

Microsoft v rámci své strategie prosazuje koncept "portfolia modelů", kde organizace využívají kombinaci různých modelů podle typu úlohy. Velké LLM fungují jako "routery", které jednoduché dotazy směřují na efektivní SLM, zatímco složitější problémy řeší samy nebo je delegují na specializované modely.

Tento hybridní přístup optimalizuje poměr výkonu a nákladů při zachování kvality. Blog Azure uvádí konkrétní příklady:

- Zemědělci v odlehlých oblastech mohou využívat modely Phi lokálně na svých zařízeních pro analýzu plodin a půdy bez nutnosti připojení ke cloudu.

- Podniky mohou implementovat specializované asistenty pro interní použití, kteří běží přímo na firemní infrastruktuře, což zvyšuje bezpečnost a snižuje latenci.

Výzvy a budoucí směřování

Přes všechny pokroky mají malé jazykové modely stále své limity. U extrémně složitých úloh nebo při potřebě rozsáhlých znalostí zůstávají velké modely nepřekonané. Microsoft však naznačuje, že budoucí vývoj se zaměří na další zmenšování "výkonnostní mezery" mezi malými a velkými modely. Dále můžeme očekávat ještě užší integraci modelů Phi do platformy Azure a nové nástroje pro snadnější implementaci a přizpůsobení těchto modelů specifickým potřebám organizací.

Hodnocení

Za pouhý rok od uvedení prvního modelu Phi se malé jazykové modely Microsoftu vyvinuly z experimentální technologie v praktické nástroje připravené pro nasazení v reálném světě. Jejich schopnost dosahovat působivých výsledků při zlomku výpočetních nákladů tradičních LLM představuje významný posun v přístupu k umělé inteligenci. S další evolucí těchto modelů můžeme očekávat, že AI bude stále dostupnější, efektivnější a přizpůsobivější širokému spektru aplikací - od podnikových asistentů přes specializované analytické nástroje až po osobní pomůcky fungující na okrajových zařízeních. Modely Phi dokazují, že v AI není vždy nutné volit mezi výkonem a efektivitou - s chytrým přístupem k designu modelů a tréninkovým datům lze dosáhnout obojího současně.