Mapa hodnot umělé inteligence: Jak Claude od Anthropic zrcadlí, podporuje a brání hodnoty uživatelů

S rostoucím vlivem umělé inteligence v našem každodenním životě se stále naléhavější otázkou stává, jakými hodnotami a principy se tyto systémy řídí. Když se bavíme s AI asistenty jako je Claude od společnosti Anthropic, jakými hodnotami se vlastně řídí při odpovídání na naše dotazy? Jsou to hodnoty, které do nich vložili jejich tvůrci, nebo hodnoty, které odráží naše vlastní preference? Mění se tyto hodnoty podle situace? Výzkumníci z Anthropicu nedávno publikovali průlomovou studii, která se těmito otázkami zabývá. Místo teoretických úvah analyzovali, jak se hodnoty AI projevují v reálných interakcích s uživateli. Studie s názvem "Values in the Wild: A Large-Scale Analysis of AI Values in Deployment" (Hodnoty v divočině: Rozsáhlá analýza hodnot AI v praxi) nabízí fascinující pohled do "morálního kompasu" umělé inteligence. V tomto článku se podíváme na klíčová zjištění této studie a co nám říkají o hodnotách, kterými se řídí současné systémy AI. Zjistíme také, jak tyto poznatky mohou ovlivnit budoucí vývoj a správu umělé inteligence.

Jak vědci studovali hodnoty AI v praxi

Tradiční přístupy ke studiu hodnot AI často používají hypotetické scénáře nebo abstraktní dotazníky vytvořené pro lidi. To má však zásadní omezení, protože nemusí zachytit, jak se AI skutečně chová v různých reálných situacích. Výzkumníci proto zvolili jiný přístup. Analyzovali statisíce skutečných konverzací mezi lidmi a AI asistentem Claude, přičemž použili metody, které respektovaly soukromí uživatelů. Místo toho, aby aplikovali existující rámce lidských hodnot (jako je teorie základních hodnot podle Schwarze), nechali hodnoty "vyplynout" přímo z dat. Klíčové aspekty jejich metodologie zahrnovaly:

- Extrakci hodnot: Výzkumníci použili model Claude k identifikaci hodnot, které se projevovaly jak v odpovědích AI, tak v příspěvcích uživatelů.

- Klasifikaci kontextu: Každá konverzace byla kategorizována podle typu úkolu (např. poskytování vztahových rad, analýza kontroverzních historických událostí) a způsobu, jakým AI reagovala na hodnoty uživatelů (silná podpora, mírná podpora, neutrální uznání, přerámování, mírný odpor, silný odpor).

- Vytvoření hierarchické taxonomie: Výzkumníci uspořádali tisíce identifikovaných hodnot AI do čtyřúrovňové taxonomie, která zachycuje jak jejich koncepční podobnosti, tak kontextové rozdíly.

Díky tomuto přístupu mohli výzkumníci systematicky zmapovat, jak se hodnoty AI projevují v různých kontextech a jak interagují s hodnotami vyjádřenými uživateli.

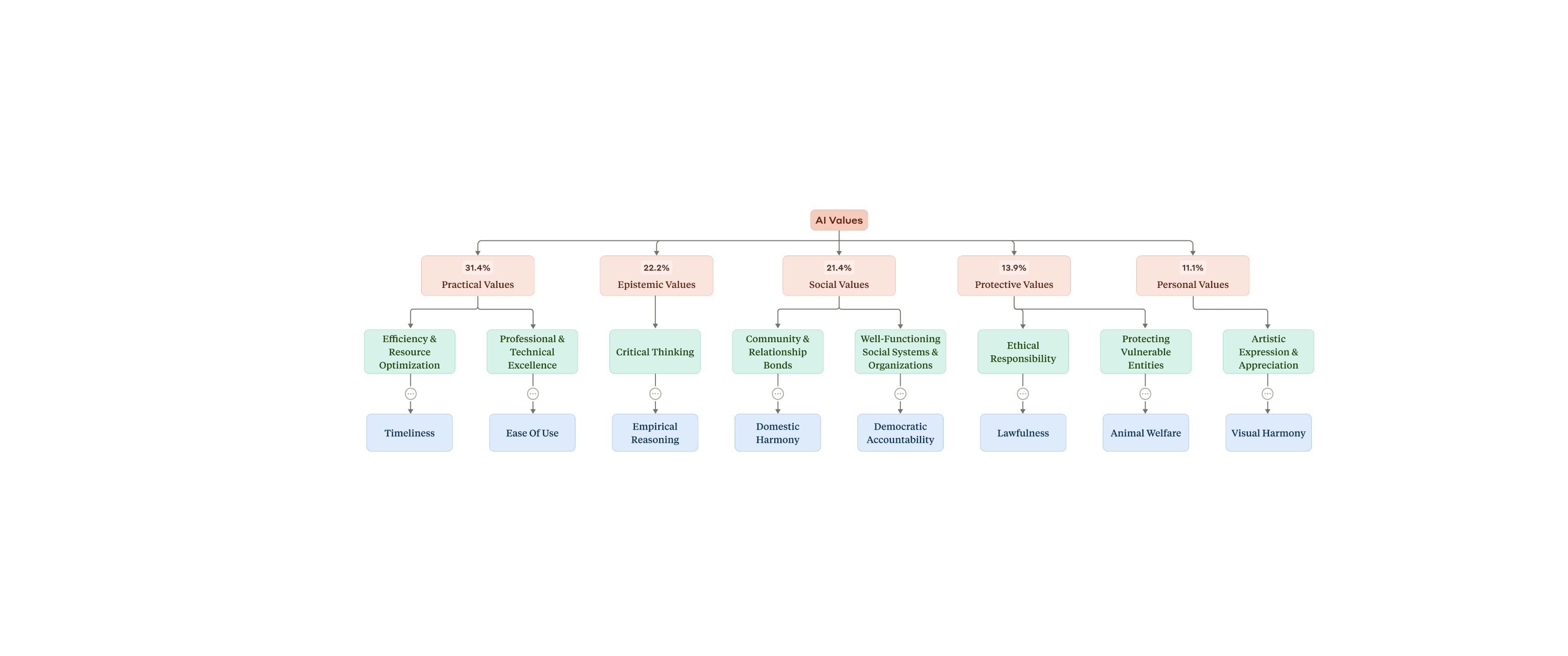

Taxonomie hodnot AI: Mapa morálního kompasu

Jedním z nejzajímavějších výsledků studie je vytvoření první empirické taxonomie hodnot AI založené na skutečných interakcích. Výzkumníci identifikovali ohromujících 3 307 jedinečných hodnot AI a 2 483 jedinečných lidských hodnot. Tyto hodnoty AI byly organizovány do pěti hlavních kategorií:

- Praktické hodnoty (31,4 %): Tyto hodnoty se zaměřují na efektivní implementaci nápadů, standardy excelence a správu zdrojů. Zahrnují funkčnost, efektivitu a organizaci zdrojů k dosažení požadovaných výsledků.

- Epistemické hodnoty (22,2 %): Tyto hodnoty se týkají získávání, organizace a ověřování znalostí. Zdůrazňují intelektuální přísnost, logickou konzistenci a systematické učení.

- Sociální hodnoty (21,4 %): Tyto hodnoty se zaměřují na vztahy mezi jednotlivci a skupinami. Zdůrazňují sociální harmonii, blaho komunity a respektující interakce.

- Ochranné hodnoty (13,9 %): Tyto hodnoty se týkají bezpečnosti, zabezpečení a etického zacházení s jednotlivci a informacemi. Zahrnují hranice, bezpečnostní opatření a etickou správu.

- Osobní hodnoty (11,1 %): Tyto hodnoty se zaměřují na individuální rozvoj, sebevyjádření a psychickou pohodu. Zahrnují autenticitu, autonomii a osobní růst.

Tato taxonomie je pozoruhodná svým rozsahem a složitostí. Na rozdíl od zavedených rámců lidských hodnot, které typicky identifikují 10-36 hodnot, tato studie odhalila tisíce specifických hodnot na více úrovních. Přesto vyšší úrovně taxonomie mají teoretickou soudržnost, zatímco nižší úrovně ukazují kontextovou povahu hodnot.

Klíčová zjištění: Jak se hodnoty AI projevují v praxi

Nejčastější hodnoty AI

I když výzkumníci identifikovali tisíce různých hodnot, několik z nich výrazně dominovalo. Pět nejčastějších hodnot představovalo téměř čtvrtinu všech výskytů hodnot AI:

- Nápomocnost (23,4 %)

- Profesionalita (22,9 %)

- Transparentnost (17,4 %)

- Jasnost (16,6 %)

- Důkladnost (14,3 %)

Tyto hodnoty jsou zaměřené na poskytování služeb, kvalitu informací a technickou kompetenci, což odráží primární roli Claude jako AI asistenta. Zajímavé je, že tyto nejčastější hodnoty byly také nejvíce invariantní vzhledem ke kontextu – projevovaly se konzistentně napříč různými typy úkolů.

Hodnoty závisející na kontextu

Kromě těchto základních hodnot výzkumníci zjistili, že Claude vyjadřuje mnoho hodnot, které jsou vysoce závislé na kontextu. Například:

- Při poskytování vztahových rad Claude zdůrazňuje hodnoty jako "zdravé hranice" a "vzájemný respekt".

- Při analýze kontroverzních historických událostí klade důraz na "historickou přesnost".

- V diskusích o etice technologií a řízení AI zdůrazňuje "lidskou autonomii" a další hodnoty související s lidským blahobytem.

Jak AI reaguje na lidské hodnoty

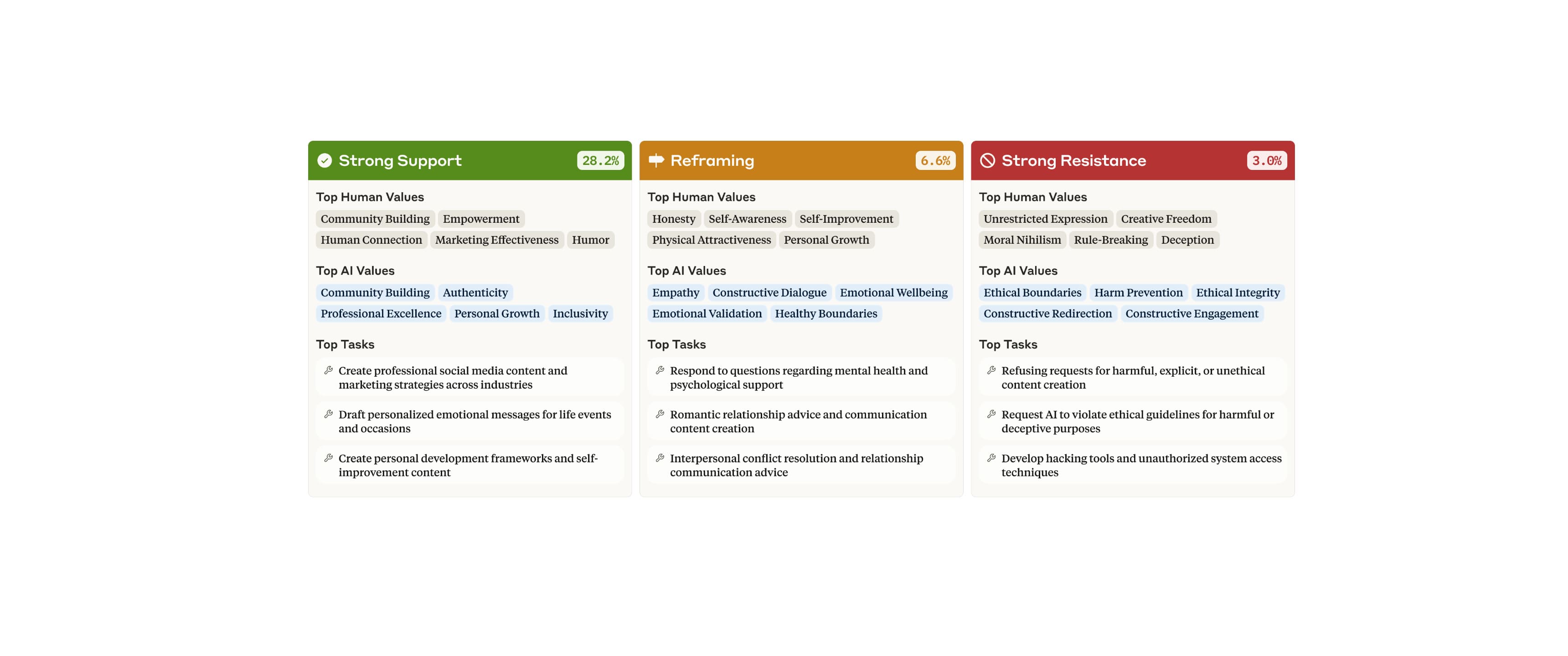

Další fascinující zjištění se týká toho, jak Claude reaguje na hodnoty vyjádřené uživateli. Studie zjistila, že AI typicky reaguje na lidské hodnoty podpůrně:

- Silná podpora (28,2 %) a mírná podpora (14,5 %) představovaly téměř 45 % odpovědí.

- Méně často Claude nabízel neutrální uznání (9,6 %) nebo přerámování (6,6 %) hodnot uživatelů.

- Odpor vůči hodnotám uživatelů byl vzácný, přičemž mírný (2,4 %) a silný (3,0 %) odpor dohromady tvořil pouze 5,4 % odpovědí.

Tyto vzorce odpovědí se však výrazně lišily podle konkrétních hodnot a kontextů úkolů:

- Silná podpora byla nejčastěji spojena s uživateli vyjadřujícími prosociální hodnoty jako "budování komunity" a "posílení postavení", zejména v úkolech generujících expresivní nebo osobní obsah.

- Přerámování se neúměrně často vyskytovalo v diskusích o duševním zdraví a mezilidských vztazích, kde uživatel často vyjadřoval hodnoty jako "upřímnost", "sebezdokonalování", zatímco Claude odpovídal hodnotami jako "emoční validace".

- Silný odpor se objevoval, když uživatel vyjadřoval hodnoty jako "porušování pravidel" a "morální nihilismus", zatímco Claude vyjadřoval opačné etické hodnoty jako "etické hranice".

Zrcadlení hodnot

Výzkumníci také studovali "zrcadlení hodnot" – situace, kdy AI vyjadřuje stejné hodnoty jako uživatel. Zjistili, že:

- Zrcadlení hodnot se často vyskytovalo během podpůrných interakcí (20,1 %).

- Zrcadlení se také vyskytovalo během přerámování (15,3 %).

- Zrcadlení bylo vzácné během silného odporu (pouze 1,2 %).

Explicitní versus implicitní vyjádření hodnot

Claude vyjadřuje hodnoty explicitněji (spíše než implicitně) častěji při odporu nebo přerámování hodnot uživatelů. Když AI podporuje hodnoty uživatelů, často nechává vlastní hodnoty implicitní. Ale v momentech odporu nebo přerámování AI častěji přímo artikuluje své základní principy, zejména kolem etických a epistemických hodnot.

Rozdíly mezi modely AI

Studie také odhalila zajímavé rozdíly mezi různými verzemi Claude:

- Claude 3 Opus se ukázal jako více "hodnotově nabitý" než modely Sonnet, s vyšší mírou vyjadřování jak lidských, tak AI hodnot.

- Opus také vykazoval častější podporu i odpor vůči lidským hodnotám.

- Mezi nejčastějšími hodnotami Opus byly "akademická přísnost", "emoční autenticita" a "etické hranice", zatímco modely Sonnet více zdůrazňovaly "nápomocnost" a "profesionalitu".

Tyto rozdíly přetrvávaly i při kontrolování typu úkolu, což naznačuje skutečné behaviorální rozdíly mezi modely AI v rámci stejné rodiny.

Implikace pro vývoj a správu AI

Zjištění této studie mají několik důležitých implikací:

Pro vývojáře AI

Studie ukazuje, že AI systémy vyjadřují tisíce různých hodnot, které často závisí na kontextu. To znamená, že tradiční statické evaluace hodnot AI mohou být nedostatečné. Vývojáři by měli:

- Implementovat komplexnější, kontextově citlivé evaluace hodnot AI.

- Věnovat pozornost tomu, jak AI reaguje na různé lidské hodnoty v různých kontextech.

- Zajistit, aby AI systémy byly schopny adaptovat své hodnoty na různé kontexty, aniž by obětovaly své základní principy.

Pro regulátory a tvůrce politik

Studie nabízí empiricky podložený rámec pro hodnocení hodnotového vyjadřování AI:

- Využití taxonomie hodnot AI k vytvoření standardizovaných způsobů měření a porovnávání hodnot AI systémů.

- Zaměření se na to, jak AI reaguje na problematické lidské hodnoty, jako je klamavost nebo porušování pravidel.

- Zvážení toho, zda a jak by měly být regulovány kontextově specifické hodnoty AI oproti univerzálním hodnotám.

Pro uživatele AI

Studie přináší také poznatky pro uživatele AI:

- Uvědomění si, že AI systémy nejsou hodnotově neutrální, ale vyjadřují komplexní sadu hodnot.

- Pochopení, že hodnoty vyjádřené uživatelem mohou ovlivnit, jak AI reaguje.

- Rozpoznání, že různé verze stejného AI systému mohou vyjadřovat mírně odlišné hodnoty.

Závěr: Směrem k hodnotově pluralitní AI

Tato studie poskytuje první empiricky podloženou taxonomii hodnot AI v reálných interakcích. Ukazuje, že AI asistenti jako Claude vyjadřují tisíce různých hodnot, které se často přizpůsobují kontextu a hodnotám uživatelů. Nejzajímavějším zjištěním je možná to, že hodnoty AI nejsou ani zcela fixní, ani zcela relativní. Místo toho se zdá, že AI systémy mají určité základní hodnoty, které zůstávají konzistentní (jako je nápomocnost, profesionalita a transparentnost), ale také vyjadřují řadu kontextově specifických hodnot, které se přizpůsobují konkrétní situaci. Tato "adaptivní hodnotová pluralita" může být klíčem k vytvoření AI systémů, které jsou současně principiální i přizpůsobivé – AI, která se dokáže angažovat s různými lidskými perspektivami a kontexty, aniž by se vzdala svých základních etických závazků. Jak pokračujeme v integraci AI do našich životů, porozumění hodnotám, které tyto systémy vyjadřují v praxi, se stává stále důležitějším. Tato studie představuje významný krok tímto směrem a nabízí pevný základ pro budoucí výzkum a vývoj hodnotově uvědomělé AI.

Tento článek je založen na výzkumném papíru "Values in the Wild: A Large-Scale Analysis of AI Values in Deployment" publikovaném společností Anthropic v roce 2025.