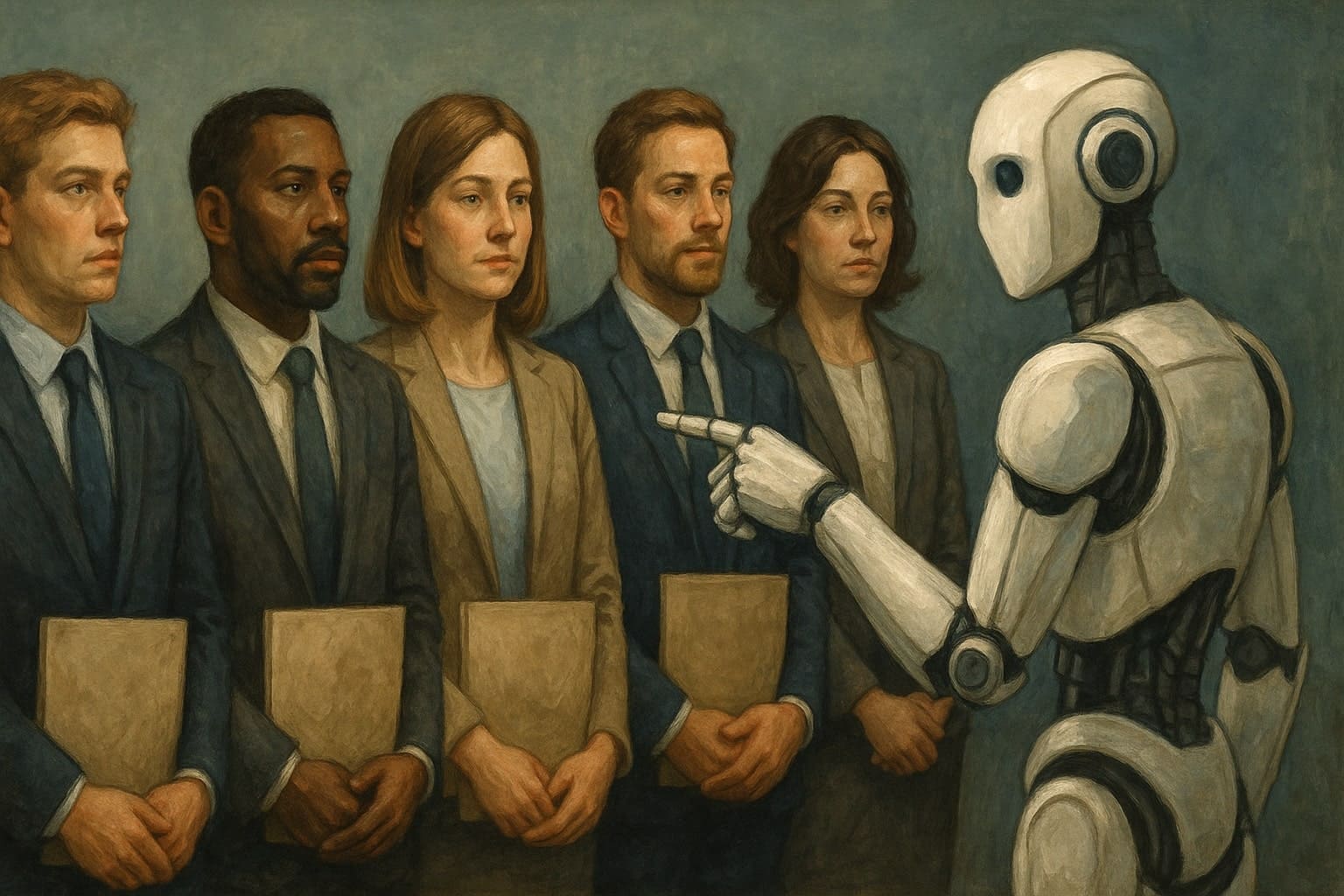

Komisařka varuje před diskriminační AI a zhoršením rasismu

Australská komisařka pro lidská práva Lorraine Finlay varovala, že umělá inteligence (AI) by mohla zhoršit rasismus a sexismus v zemi, pokud nebude pod silným regulačním dohledem. Podle jejích slov se algoritmická předpojatost – kde se předsudky z datových sad přenáší do systémů strojového učení – může kombinovat s automatizační předpojatostí, což vede lidi k přílišné důvěře v UI výstupy a přijímání diskriminačních výsledků jako neutrálních nebo objektivních. To by mohlo způsobit, že diskriminace se stane "neviditelnou" a hluboce zakořeněnou v automatizovaných rozhodovacích procesech.

Rizika diskriminace v náboru pracovníků

Australský výzkum zveřejněný v květnu 2025 odhaduje, že asi 30 % australských zaměstnavatelů používá UI nástroje pro nábor, a toto číslo by mělo v příštích pěti letech růst. Studie, kterou provedla výzkumnice z Právnické fakulty Univerzity v Melbourne Natalie Sheard, upozorňuje na rizika diskriminace kandidátů na pracovní místa, kteří jsou pohovorováni AI systémy. Například lidé s akcenty nebo postižením ovlivňujícím řeč by mohli být znevýhodněni, protože datové sady používané k trénování AI často neodrážejí demografické skupiny v Austrálii.

Sheard ve svém výzkumu vyslechla 18 specialistů na lidské zdroje v Austrálii, z nichž 13 používalo AI systémy pro nábor. Nejběžnější byly systémy pro analýzu životopisů, následované systémy pro video pohovory. Jeden z příkladů z výzkumu ukazuje, že společnost s AI systémem měla jen 6 % trénovacích dat z Austrálie nebo Nového Zélandu, přičemž 36 % uchazečů v datech bylo bílých. Chybovost při transkripci slov pro rodilé mluvčí angličtiny v USA je méně než 10 %, ale pro nerodilé mluvčí s akcenty z jiných zemí stoupá na 12 až 22 %, například pro mluvčí z Číny.

Účastníci výzkumu popsali, jak nerodilí mluvčí angličtiny nebo lidé s postižením řeči mohou mít svá slova špatně transkribována, což vede k nízkému hodnocení algoritmem. Dva z nich požadovali od dodavatele AI softwaru ujištění, že systém neznevýhodňuje kandidáty s akcenty, a dostali odpověď, že AI je "opravdu dobrá v porozumění akcentům", ale bez jakéhokoli důkazu.

Transparentnost a regulace

Lorraine Finlay zdůraznila nedostatek transparentnosti v datových sadách pro trénování AI, což ztěžuje identifikaci a opravu inherentních předpojatostí. Varuje, že snaha o produktivitu prostřednictvím AI nesmí jít na úkor lidských práv a cílů proti diskriminaci. Tato varování přicházejí uprostřed politické debaty ve vládě o regulaci AI. Například senátorka a bývalá výzkumnice v oblasti AI Michelle Ananda-Rajah argumentuje, že uvolnění australských dat pro trénování AI by mohlo snížit předpojatost tím, že systémy budou lépe odrážet místní diverzitu, místo aby udržovaly předpojatost z modelů trénovaných v zahraničí.

Ananda-Rajah se staví proti samostatnému zákonu o AI, ale podporuje kompenzaci australských tvůrců obsahu za použití jejich dat v trénování. Média a umělecké organizace vyjádřily obavy z možného zneužití australského obsahu velkými technologickými firmami a volají po silnější ochraně autorských práv a soukromí.

Doporučení a budoucí kroky

Sheard ve své studii zdůraznila, že neexistuje žádný případ diskriminace způsobené AI, který by dospěl k soudům v Austrálii – všechny musí nejprve projít Australskou komisí pro lidská práva. V roce 2022 federální komisař pro ochranu zásluh zrušil 11 rozhodnutí o povýšení v agentuře Services Australia poté, co agentura outsourcovala proces na specialistu používajícího AI techniky, včetně psychometrického testování, dotazníků a videoodpovědí nahraných kandidáty. Bylo zjištěno, že proces "ne vždy splňoval klíčový cíl výběru nejschopnějších kandidátů".

Sheard navrhuje, aby vláda Anthonyho Albanese zvážila specifický zákon o AI pro regulaci jejího používání a posílila stávající zákony proti diskriminaci, aby chránily před diskriminací založenou na AI. Bez těchto opatření by podle Finlay a dalších stakeholderů mohla AI prohloubit existující rasové a genderové nerovnosti v Austrálii, což by je učinilo těžšími k odhalení a řešení.