Anthropic mění podmínky: Claude chce využívat data uživatelů pro AI trénink

Společnost Anthropic, která vyvinula AI chatbot Claude, chystá změny v pravidlech ochrany dat. Do 28. září se všichni uživatelé musí rozhodnout, zda jejich konverzace budou používány pro budoucí trénink modelů, a to po dobu dalších 5 let. To je změna oproti dosavadní politice, kdy konverzace využívány nebyly a data byla po 30 dnech automaticky mazána.

Změna se dotkne uživatelů služeb Claude Free, Pro, Max i uživatelů Claude Code. Aktivní je už nyní.

Nenápadné oznámení namísto velké zprávy

Diskuze okolo zaváděné novinky se rozpoutaly především kvůli způsobu, jakým společnost nové zacházení s daty uživatelům oznámila. Zpráva o nových pravidlech ochrany a zpracování dat se objevila jako jedna z novinek na webu společnosti.

Díky tomu tuto změnu mnoho lidí nezaznamenalo a možná nevědomky udělí souhlas s využitím konverzací a kódovacích relací, i přesto, že mohou odmítnout. Důvodem je totiž nenápadný způsob, kterým si Claude souhlas vyžádá.

Vyskakovací okno? Čtěte pozorně!

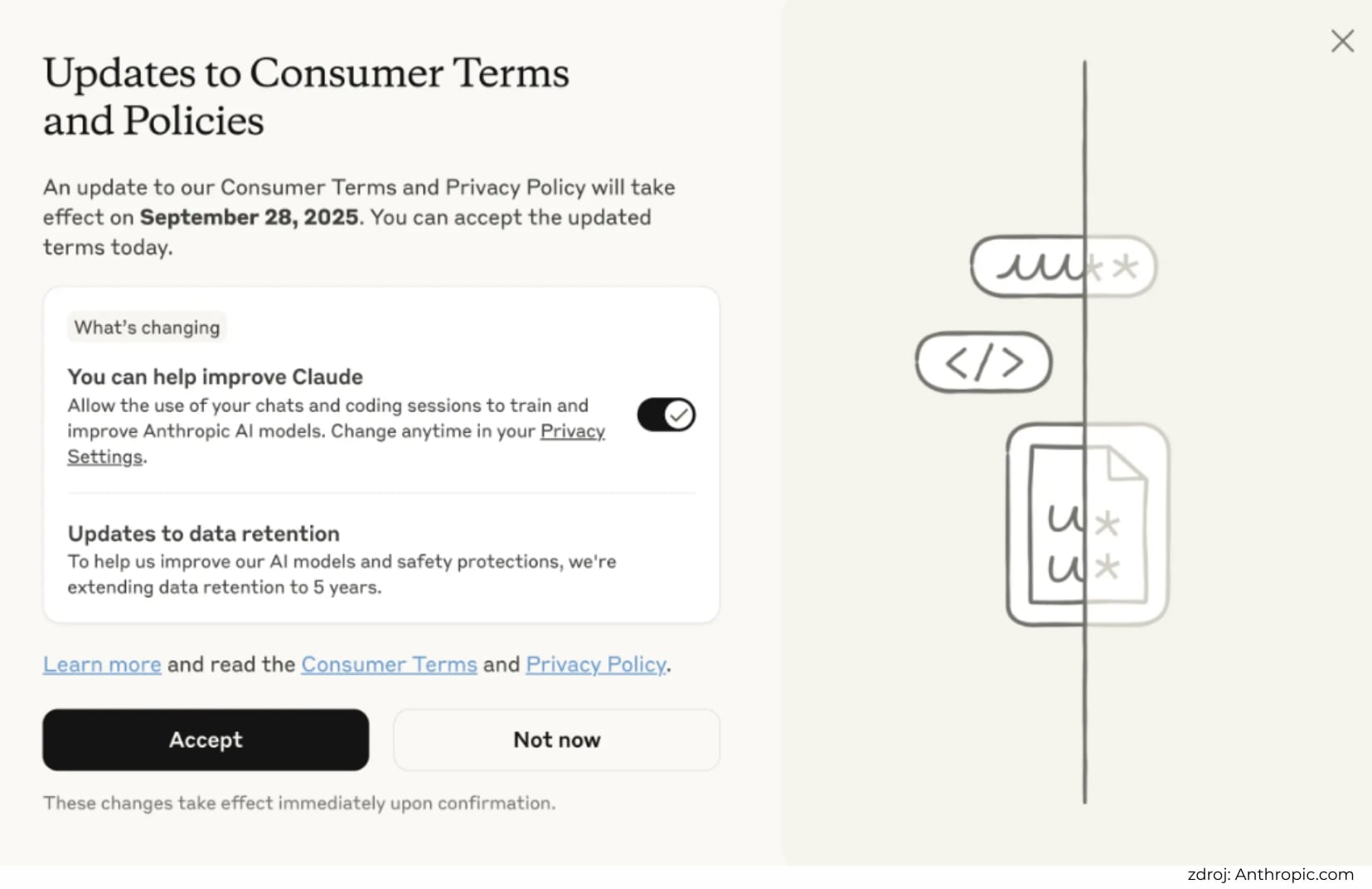

Noví uživatelé se o zpřístupnění svých dat rozhodnou již při registraci. Ti stávající narazí na vyskakovací okno s výzvou k souhlasu. Rozhraní tohoto okna však vypadá jen jako oznámení o běžných změnách a na první pohled oznamuje „pouze“ aktualizaci podmínek a zásad pro spotřebitele, k čemuž je připojeno velké tlačítko „přijmout“. Právě tímto potvrzením však zpřístupňujete své konverzace společnosti Anthropic a ta s nimi může pracovat po dobu 5 let.

Zamítnout tuto změnu je snadné – stačí pouze v kolonce You can help improve Claude přepnout tlačítko do vypnuté polohy. Tím zajistíte, že vaše konverzace s chatbotem nebudou využívány a budou i nadále mazány po 30 dnech. Design oznámení a automatické souhlasné nastavení však může přispět k pasivnímu předání osobních dat společnosti.

Pro trénink chce společnost Anthropic použít pouze nové nebo obnovené konverzace. Starých chatů se proto změna netýká.

Proč Anthropic zavádí změny

Anthropic uvádí, že chystané změny mají posílit bezpečnost AI modelů a zdokonalit jejich schopnosti. Právě uživatelská data totiž mohou vylepšit reakce modelu, pomoci odhalit nebezpečný nebo škodlivý obsah, pozvednout jeho logické a analytické myšlení nebo zefektivnit dovednosti v oblasti kódování. Uložení dat po dobu 5 let má navíc jazykovým modelům lépe pochopit vzorce a návaznosti mezi nimi.

Podle TechCrunch má však sběr reálných dat a konverzací nejen zlepšit uživatelskou zkušenost, ale také přinést společnosti konkurenční výhodu. Skutečné lidské interakce s chatbotem jsou totiž pro trénink modelů velmi cenné. A tím, že společnost Anthropic jich dostane obrovské množství, si může zajistit náskok před dalšími AI giganty jako je Google nebo OpenAI.

Dopady změn na uživatele

Trénink modelu na reálných konverzacích může přinést nejen jeho zlepšení a zkvalitnění, ale také jeho rychlejší růst. Společnost Anthropic navíc ve své zprávě uživatele ujišťuje, že data budou i nadále v bezpečí a nebudou poskytována třetí straně. Problém však pro mnohé uživatele představuje způsob, kterým Anthropic souhlas získá.

Pokud si uživatelé AI asistenta Clauda chtějí uchovat i nadále svá data v soukromí a neposkytnout je pro trénink stávajících i nových modelů, musí být při schválení nových podmínek obezřetní.

Zdroj: TechCrunch, The Verge, TechEDT