Vědci z University of Washington provedli studii, ve které se umělá inteligence (AI) dokázala naučit kulturní hodnoty pozorováním lidského chování. Tento přístup napodobuje, jak děti vstřebávají hodnoty ze svého okolí. Výzkum, publikovaný v časopise PLOS One, se zaměřil na altruismus – chování, kdy člověk pomáhá druhým na úkor sebe. Autoři studie testovali AI na datech z online hry.

Studie vychází z předchozího výzkumu, který zjistil, že 19měsíční děti z latinskoamerických a asijských domácností jsou náchylnější k altruismu než děti z jiných kultur. Vědci chtěli zjistit, zda se AI může podobně naučit hodnoty pozorováním. Proto rekrutovali 190 dospělých, kteří se identifikovali jako bílí, a 110 jako Latinoameričané. Každá skupina měla přiřazeného AI agenta, který se učil z jejich chování.

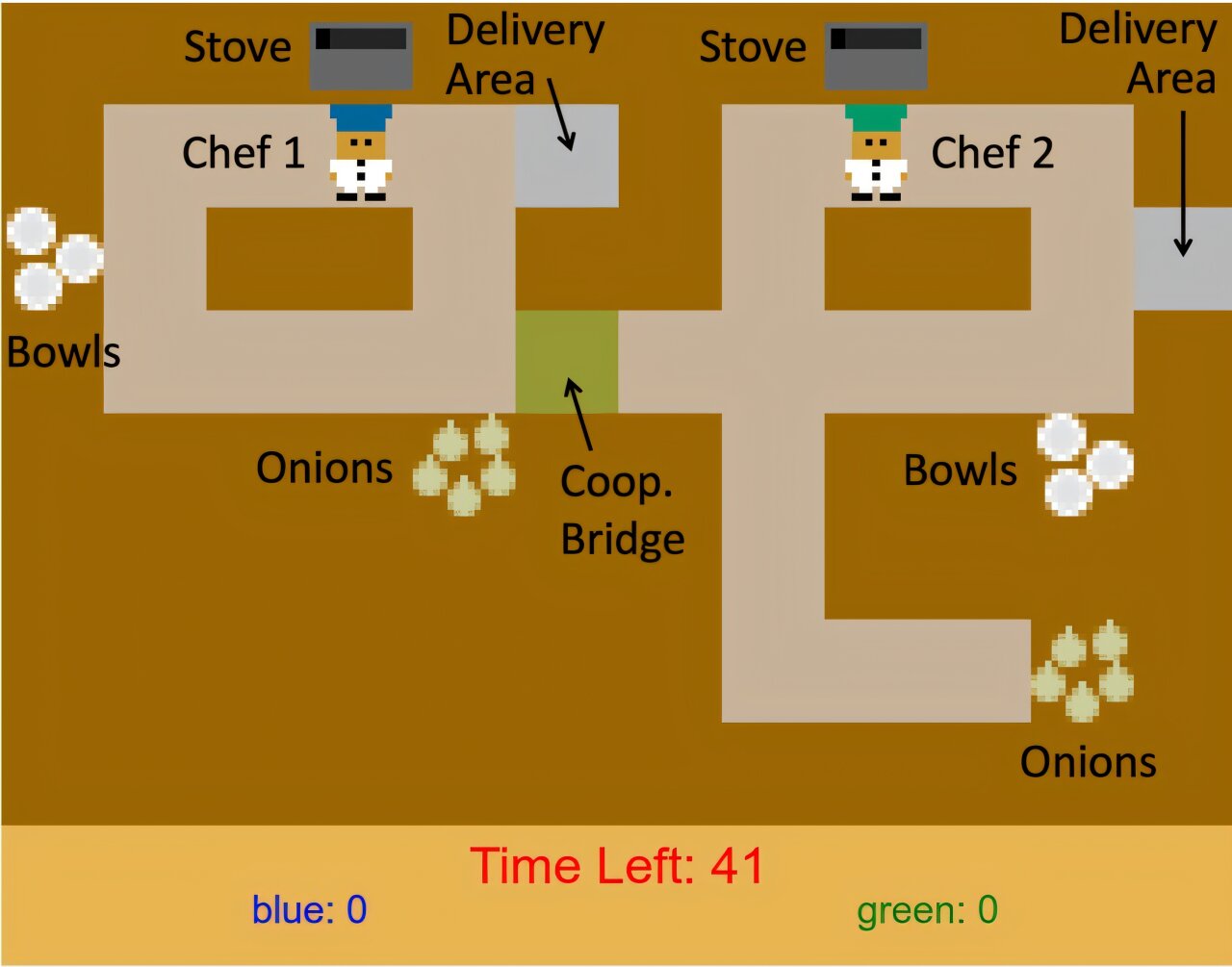

Test probíhal na hře Overcooked

Experiment využil upravenou verzi videohry Overcooked, kde hráči vaří a doručují cibulovou polévku. Hráči ovládají kuchaře v kuchyni, kde musí sbírat cibule, vařit je v hrnci a doručovat. V upravené verzi má jeden hráč výhodu – kratší cestu k cibulím – zatímco druhý musí překonávat delší vzdálenost. Hráči mohou sdílet cibule přes "most spolupráce", což je altruistický akt, protože to snižuje jejich vlastní skóre.

Účastníci hráli tři kola. V prvním a třetím kole ovládali kuchaře s výhodou, v druhém s nevýhodou. Druhý hráč byl ve skutečnosti bot ovládaný počítačem, který v druhém kole buď pomáhal (sdílel cibule) nebo ne. Latinoameričtí účastníci v prvním kole sdíleli průměrně 0,24 cibule na doručenou polévku (s odchylkou 0,28), zatímco bílí jen 0,14 (s odchylkou 0,21). To potvrdilo, že Latinoameričané projevovali vyšší altruismus.

AI agenti se učili metodou inverzního posilování učení (inverse reinforcement learning, IRL). Na rozdíl od běžného posilování učení, kde AI dostává odměny za cíle, IRL odvozuje odměny z pozorovaného chování. Agenti se tak naučili "odměnovou funkci" – hodnoty přiřazené k akcím, jako je sdílení cibule.

Výsledek: AI se přizpůsobuje kulturám

AI trénovaný na datech od Latinoameričanů sdílel více cibulí než ten trénovaný na bílých. Například funkce odměn přiřadila vyšší hodnotu situaci, kdy má druhý agent cibuli, u Latinoameričanů. Agenti generalizovali toto učení do nových scénářů. V šesti variantách hry s jiným uspořádáním kuchyně (například delší nebo kratší cesty k mostu) si AI udržel altruistické tendence své skupiny.

Silnější generalizace proběhla v novém úkolu "Udržet nebo darovat". Zde AI rozhodovala, zda darovat část svých úspor (v libovolných jednotkách) jinému agentovi v nouzi. Oba agenti čelili náhodným výdajům (1 jednotka s pravděpodobností 80 %, 2 jednotky s 20 %) a dostávali "mzdu" – AI 5 až 15 jednotek každých 6 až 10 kroků, druhý jen 2 jednotky. AI trénovaná na Latinoameričanech darovala častěji, zejména když měla vyšší zůstatek a druhý agent byl na nule.

Závěrečné detaily ze studie

Výzkum ukázal, že AI může naučit altruismus implicitně, bez explicitního programování. Agenti trénovaní na Latinoameričanech měli vyšší "poměr sdílení" – poměr odměn za sdílení versus vaření. Studie zahrnovala funkce jako "cibule v hrnci" nebo "druhý agent má cibuli", které AI použila k rozhodování.

Tento přístup by mohl umožnit AI přizpůsobit se různým kulturám, kde se hodnoty liší. Vědci zdůrazňují potřebu dalšího testování v reálných scénářích s více kulturami.