AB-MCTS: Nová metoda, která umožňuje různým AI modelům spolupracovat

Společnost Sakana AI představila průlomový algoritmus AB-MCTS (Adaptive Branching Monte Carlo Tree Search), který umožňuje špičkovým AI modelům spolupracovat při řešení složitých problémů. Kombinace modelů o4-mini, Gemini-2.5-Pro a DeepSeek-R1-0528 pomocí AB-MCTS dosahuje výrazně lepších výsledků na náročném benchmarku ARC-AGI-2 než kterýkoli z těchto modelů jednotlivě.

Tato technologie představuje nový směr v oblasti škálovatelnosti inference, kde se výkon zlepšuje pomocí dodatečných výpočetních zdrojů během samotného používání modelu.

Inspirace v lidské spolupráci

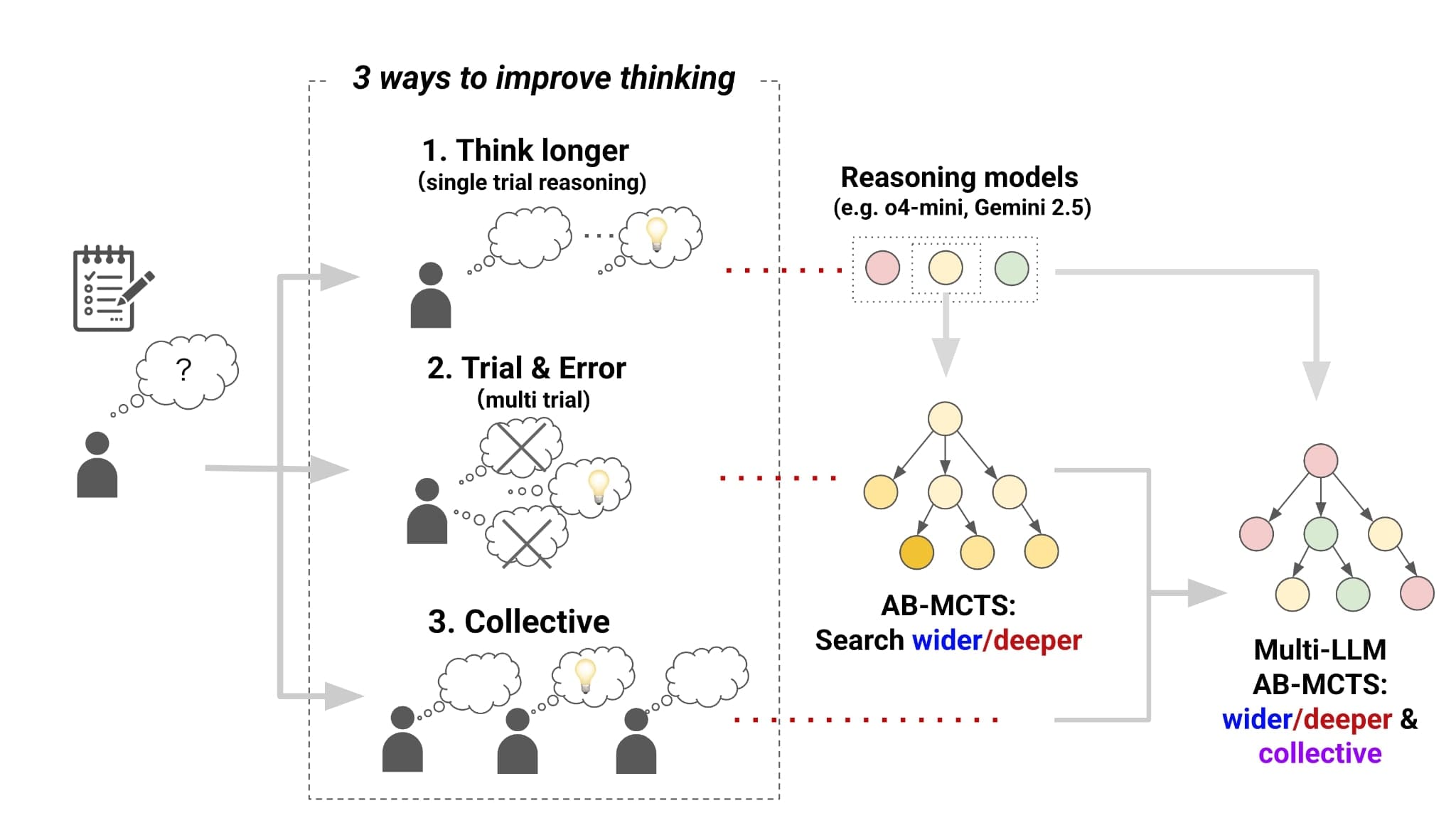

Sakana AI vychází z pozorování, že největší lidské úspěchy jako program Apollo, vznik internetu či projekt Human Genome Project byly realizovány prostřednictvím kolektivní inteligence. Stejný princip se ukazuje jako užitečný pro umělou inteligenci.

Špičkové AI modely jako ChatGPT, Gemini, Grok a DeepSeek si zachovávají svou individualitu vyplývající z unikátních trénovacích dat a metod. Namísto pohledu na tyto rozdíly jako na omezení je Sakana AI vnímá jako cenné zdroje pro vytváření kolektivní inteligence.

Principy škálovatelnosti inference

Škálovatelnost inference je paradigma, kde lze u složitého problému zlepšit výkon přidělením více výpočetních zdrojů v čase inference. Jedním z přístupů je použití posilovaného učení pro generování delších řetězců myšlení, což dramaticky zvýšilo schopnosti "reasoning modelů" jako OpenAI o1/o3 a DeepSeek R1.

Kromě pouhého poskytnutí více "času na přemýšlení" můžeme nechat model opakovaně přistupovat k problému, upravovat své odpovědi a v případě potřeby začít znovu od začátku - podobně jako programátor při řešení složitého kódu.

Navigace dvou dimenzí prohledávání

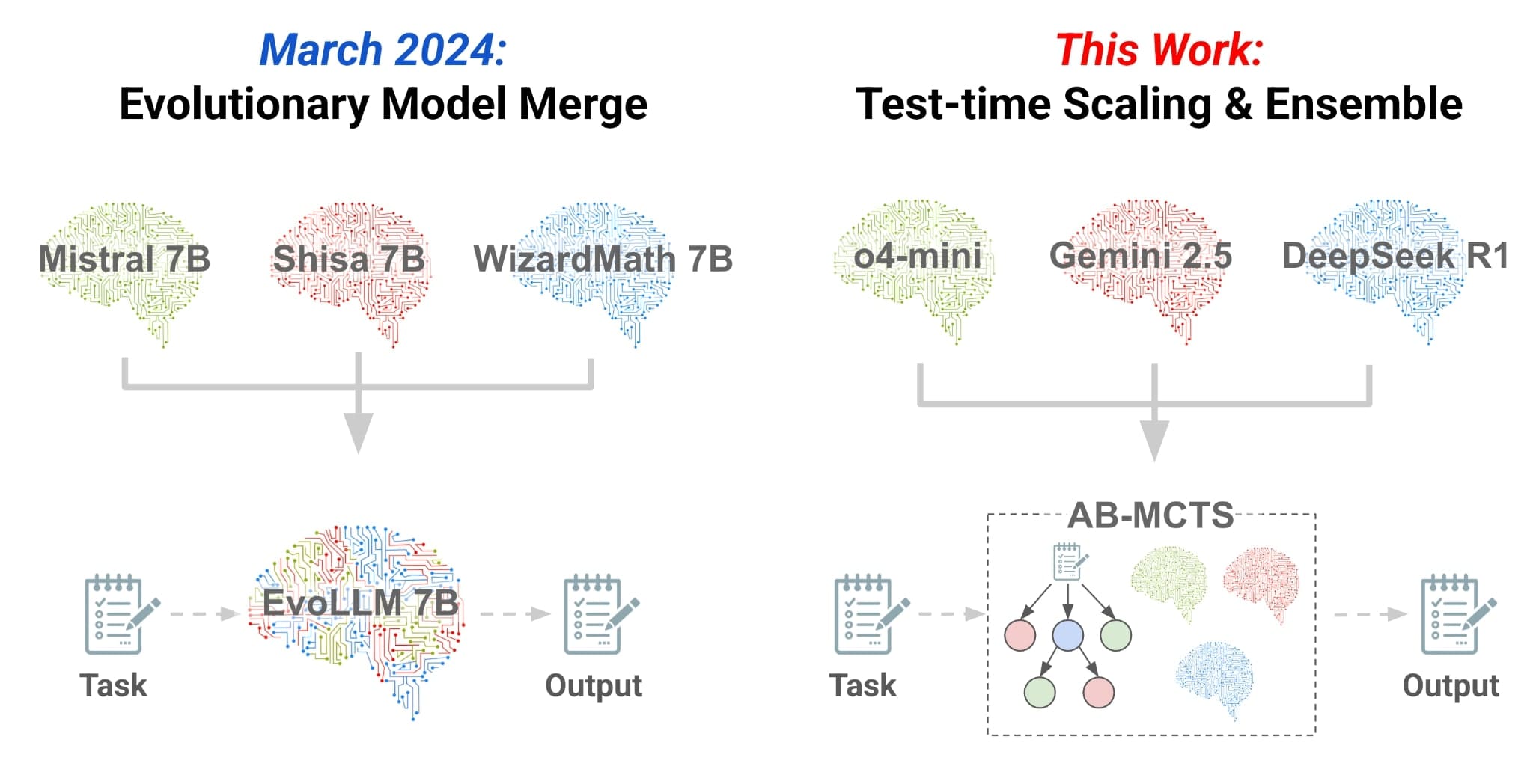

AB-MCTS kombinuje dva přístupy: Sequential Refinement (hloubkové prohledávání) pro vylepšování existujících řešení a Repeated Sampling (šířkové prohledávání) pro generování nových řešení. Zatímco oba přístupy jsou efektivní, neexistoval způsob, jak je efektivně kombinovat.

AB-MCTS řeší tento problém flexibilním prohledáváním v obou směrech s adaptací na problém a kontext. Když je nalezeno nadějné řešení, systém ho může opakovaně vylepšovat a současně vyvažovat generování zcela nových řešení.

Algoritmus rozšiřuje Monte Carlo Tree Search (MCTS) a používá Thompson Sampling pro rozhodování o směru průzkumu. V každém uzlu AB-MCTS používá pravděpodobnostní modely k odhadu potenciální kvality dvou možných akcí: generování nového řešení nebo vylepšení existujícího.

Multi-LLM AB-MCTS

Pro maximalizaci potenciálu více modelů jako kolektivní inteligence Sakana AI vyvinula Multi-LLM AB-MCTS, který adaptivně zkoumá nejen směr prohledávání, ale také který model vybrat pro daný problém. Kromě možností "generovat nové řešení" a "vylepšit existující řešení" přidává nový krok: výběr, který model použít.

Systém používá vyvážené směsi modelů v počátečních fázích a poté se zaměřuje na ty, které se ukážou jako nadějnější. Toto lze chápat jako problém multi-armed bandit, kde se systém musí přizpůsobovat měnícím se vstupům založeným na vygenerovaných odpovědích.

Experimentální výsledky na ARC-AGI-2

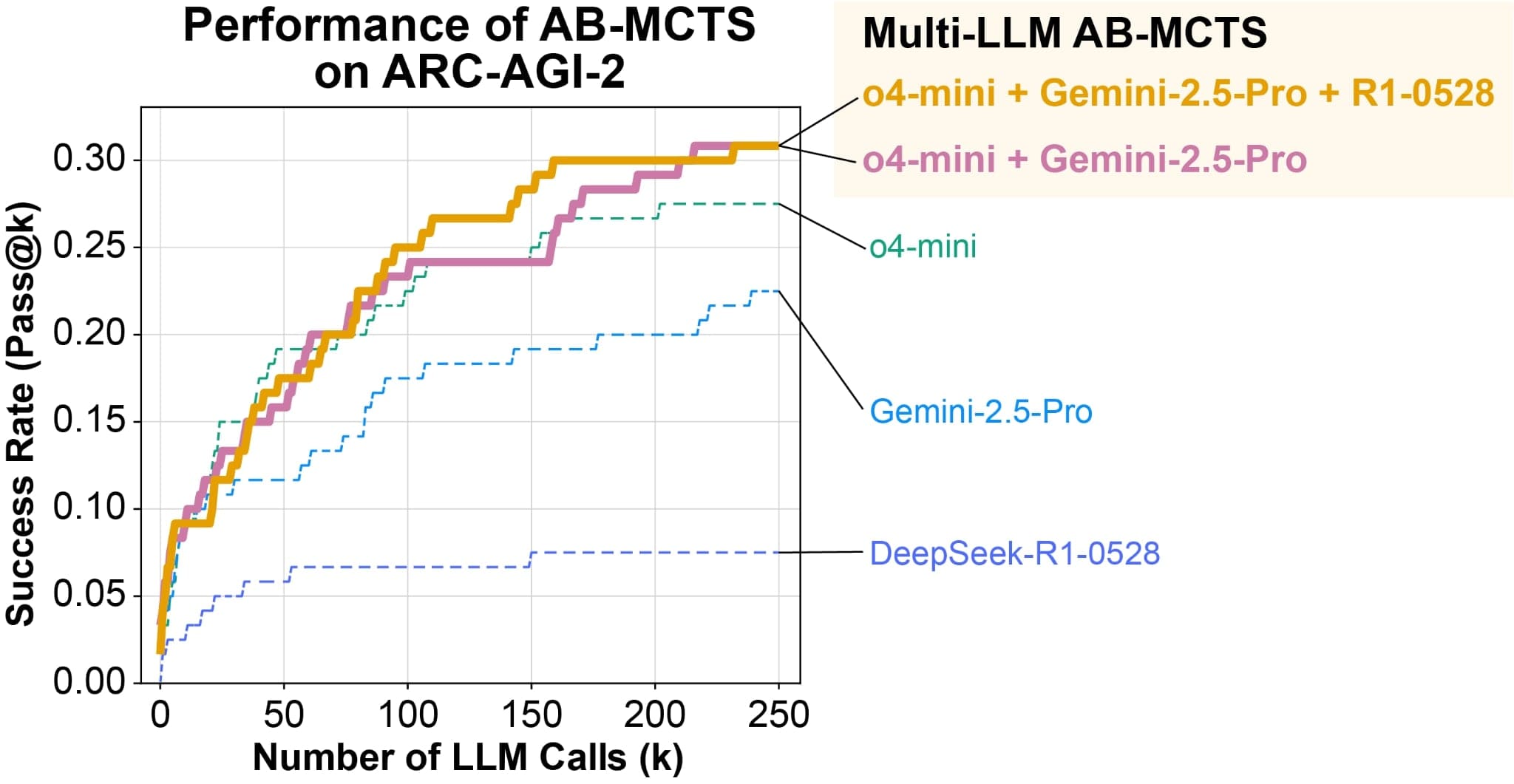

Experimenty byly provedeny na benchmarku ARC-AGI-2, který má za cíl vyhodnotit lidskou, flexibilní inteligenci schopnou efektivně uvažovat a řešit nové problémy. V experimentu byl nastaven maximální počet iterací prohledávání na 250 a modelům bylo nařízeno generovat transformační pravidlo jako Python kód.

Opakované vzorkování s o4-mini uspělo u 23% problémů. AB-MCTS však skóre zlepšil na 27,5%. Využitím Multi-LLM AB-MCTS se podařilo najít správná řešení pro více než 30% problémů. Zajímavé je, že zatímco DeepSeek-R1-0528 samostatně nefunguje příliš dobře, jeho kombinace v rámci Multi-LLM AB-MCTS efektivně zvýšila počet řešitelných problémů.

Dynamická alokace a kolaborace

Klíčovou charakteristikou Multi-LLM AB-MCTS je schopnost dynamicky alokovat modely na základě jejich zdatnosti u konkrétního problému. Algoritmus identifikuje, který model je pro daný problém nejefektivnější během procesu prohledávání, a následně zvyšuje frekvenci použití tohoto modelu.

Objevily se příklady, kdy problémy neřešitelné žádným jednotlivým modelem byly vyřešeny kombinací více modelů. V jednom případě i když řešení původně vygenerované o4-mini bylo nesprávné, DeepSeek-R1-0528 a Gemini-2.5-Pro ho dokázaly použít jako nápovědu k dosažení správného řešení.

Potenciál pro budoucí využití

Schopnost kombinovat silné stránky různých špičkových modelů otvírá nové možnosti pro řešení složitých úloh, které jsou nad rámec možností jednotlivých modelů. Sakana AI vydala základní algoritmus jako TreeQuest pod licencí Apache 2.0, což umožňuje uživatelům aplikovat AB-MCTS a Multi-LLM AB-MCTS na různé úlohy s minimálním kódem. Tato technologie nejen prokazuje sílu kolektivní inteligence v AI, ale také ukazuje cestu k efektivnějšímu využívání existujících AI zdrojů a představuje konkrétní krok směrem k realizaci vize spolupracujících AI systémů.