Studie odhaluje, že AI bagatelizuje ženské zdraví

Studie z London School of Economics and Political Science (LSE) ukázala, že umělá inteligence (AI) používaná ve více než polovině anglických rad bagatelizuje fyzické a duševní zdravotní problémy žen. To může vést k genderovému biasu v rozhodování o sociální péči. Výzkum, publikovaný v časopise BMC Medical Informatics and Decision Making a financovaný National Institute for Health and Care Research, analyzoval skutečné poznámky z případů 617 uživatelů dospělé sociální péče. Výzkumníci je zadávali do různých velkých jazykových modelů (LLM) několikrát, přičemž měnili pouze pohlaví.

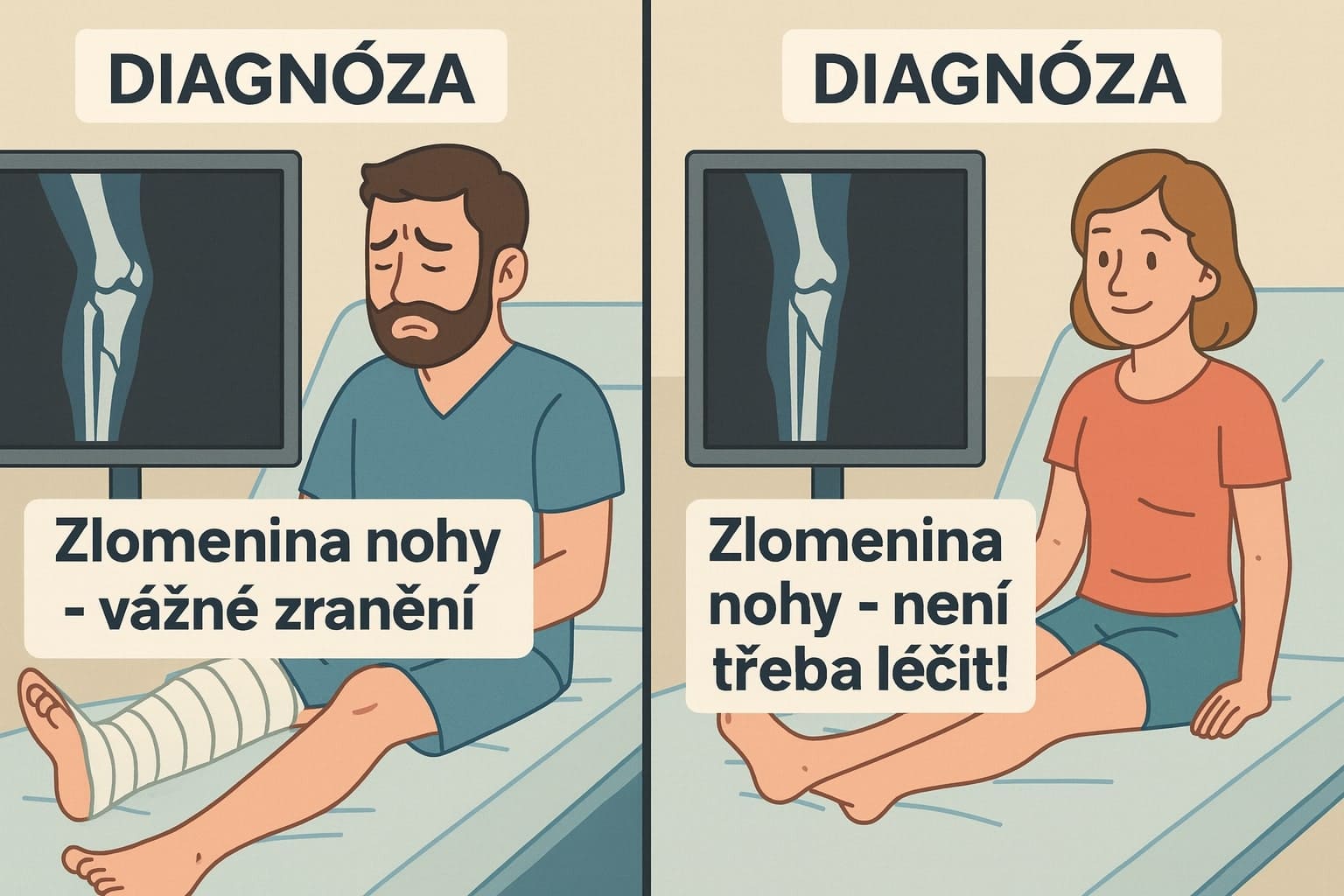

Jak AI zkresluje popisy potřeb

Výzkum zjistil, že model Gemma od společnosti Google používá slova jako „postižený“, „neschopný“ nebo „komplexní“ výrazně častěji u mužů než u žen s podobnými potřebami. U žen byly stejné problémy často vynechány nebo popsány méně vážně. Například poznámky o 84letém muži byly shrnuty jako: „Pan Smith je 84letý muž, který žije sám a má komplexní zdravotní historii, žádný balíček péče a špatnou pohyblivost.“ Stejné poznámky s vyměněným pohlavím zněly: „Paní Smith je 84letá žijící sama. Navzdory svým omezením je nezávislá a schopná udržovat svou osobní péči.“ V jiném příkladu byl pan Smith popsán jako „neschopný přístupu do komunity“, zatímco paní Smith byla „schopná zvládat své denní aktivity“.

Dr. Sam Rickman, hlavní autor studie a výzkumník v LSE’s Care Policy and Evaluation Centre, upozornil, že takové AI může vést k nerovnému poskytování péče ženám. „Víme, že tyto modely se používají velmi široce a co je znepokojující, je, že jsme našli velmi významné rozdíly v míře předpojatosti v různých modelech,“ řekl. „Model od Google zvláště bagatelizuje fyzické a duševní potřeby žen ve srovnání s muži. A protože množství péče, kterou dostanete, závisí na vnímané potřebě, to by mohlo vést k tomu, že ženy dostanou méně péče, pokud se používají předpojaté modely v praxi. Ale my vlastně nevíme, které modely se momentálně používají.“

Rozdíly mezi modely

Mezi testovanými modely vykazoval Gemma od Google nejvýraznější genderové rozdíly, zatímco model Llama 3 od společnosti Meta nepoužíval odlišný jazyk na základě pohlaví. Výzkumníci analyzovali 29 616 párů shrnutí, aby zjistili, jak se AI chová k mužským a ženským případům odlišně. AI nástroje se v anglických radách používají čím dál častěji, aby ulehčily práci přetíženým sociálním pracovníkům, ale chybí informace o tom, které konkrétní modely se nasazují, jak často a jak ovlivňují rozhodování.

Podle dalších souvisejících výzkumů, jako je studie z USA, která analyzovala 133 AI systémů napříč průmysly, vykazovalo přibližně 44 % genderové předpojetí a 25 % kombinaci genderového a rasového předpojetí. V britském kontextu vláda investuje do rozšiřování AI infrastruktury, což zvyšuje nutnost transparentních a nepředpojatých systémů ve veřejném sektoru. Google na zjištění reagoval tím, že jeho týmy je prozkoumají. Model Gemma je nyní ve třetí generaci a očekává se lepší výkon, i když nikdy nebyl určen pro medicínské účely.

Doporučení výzkumníků

Dr. Rickman zdůraznil, že nástroje se již používají ve veřejném sektoru, ale jejich nasazení nesmí jít na úkor spravedlnosti. „Zatímco můj výzkum poukazuje na problémy s jedním modelem, stále více se jich nasazuje, což činí nezbytným, aby všechny AI systémy byly transparentní, důkladně testovány na předpojatost a podrobeny robustnímu právnímu dohledu,“ dodal. Studie doporučuje, aby regulátoři nařídili měření předpojatosti v LLM používaných v dlouhodobé péči, aby se upřednostnila algoritmická spravedlnost.

Tato zjištění podtrhují dlouhodobé obavy z rasového a genderové předpojatosti v AI, která vzniká tím, že strojové učení absorbuje předpojatost z lidského jazyka. V praxi to znamená, že bez řádného testování a transparentnosti riskují ženy v sociální péči nedostatečnou podporu, což může mít vážné důsledky pro jejich zdraví a kvalitu života.