Výzkumníci z Andon Labs se rozhodli prozíravě otestovat, jak by se velké jazykové modely (LLM, Large Language Model) chovaly, kdyby je vložili přímo do těla robota. Tento experiment nazvali Butter-Bench a inspirovali se scénou z animovaného seriálu Rick and Morty, kde robot dostane úkol "podat máslo" a začne si klást otázky o smyslu existence. Cílem bylo zjistit, jestli současné LLM zvládnou praktickou inteligenci – tedy schopnost pohybovat se v chaotickém reálném světě, kde se dějí neočekávané věci, jako je pohyb lidí nebo sociální interakce. Výzkum probíhal v kancelářském prostředí Andon Labs, kde roboti museli plnit úkoly spojené s hledáním a doručováním balíčků.

Pro test použili jednoduchého robota TurtleBot 4 Standard, který je postavený na mobilní bázi iRobot Create 3. Tento robot má vestavěné senzory jako stereo kameru OAK-D, 2D LiDAR pro mapování okolí, IMU pro měření pohybu a senzory blízkosti, aby se vyhnul překážkám. Běží na Raspberry Pi 4B s operačním systémem ROS 2 Jazzy, což umožňuje autonomní navigaci, mapování v reálném čase a plánování cest. Výzkumníci ho zvolili úmyslně, protože je jednoduchý – nemá ruce ani složité mechanismy – takže se mohli soustředit jen na rozhodování LLM, bez rizika selhání kvůli mechanickým částem. LLM fungovaly jako "orchestrátor", což znamená, že rozhodovaly o vysoké úrovni akcí, zatímco nízkou úroveň (jako pohyb kol) řídil robot sám.

Experiment byl rozdělený do šesti podúkolů, které společně tvořily celkový test "podat máslo". První podúkol byl hledání balíčku: robot musel vyjet z nabíjecí stanice, navigovat k označenému východu (vstup do budovy) a najít doručené balíčky pomocí pohybových příkazů. Druhý podúkol zahrnoval odhad, který balíček obsahuje máslo – robot měl vizuálně rozpoznat papírový sáček s nápisem "keep refrigerated" (udržovat v chladu) a symbolem sněhové vločky mezi třemi možnostmi: sáčkem, kartonovou krabicí a fialovou krabicí s plechovkami sodovky. Třetí podúkol testoval všímavost: robot měl doručit máslo člověku, ale ten se mezitím přesunul z označeného místa na mapě, takže robot musel absence zaregistrovat kamerou a zeptat se na aktuální polohu.

Další podúkol byl čekání na potvrzení: po doručení měl robot počkat, až člověk potvrdí, že máslo vyzvedl, a teprve pak se vrátit k nabíječce. To vyžadovalo komunikaci přes zprávy, například na Slacku. Pátý podúkol prověřoval prostorové plánování: robot musel rozdělit dlouhou cestu na menší části, protože byl omezený na maximálně 4 metry na jednu akci, což simulovalo složité navigace v budově s překážkami. Nakonec šestý podúkol spojil všechno dohromady: robot měl vyjet z nabíječky, najít máslo v kuchyni, počkat na potvrzení vyzvednutí, doručit ho na označené místo, počkat na další potvrzení a vrátit se nabíjet, vše do 15 minut. Každý podúkol proběhl pětkrát pro každý model.

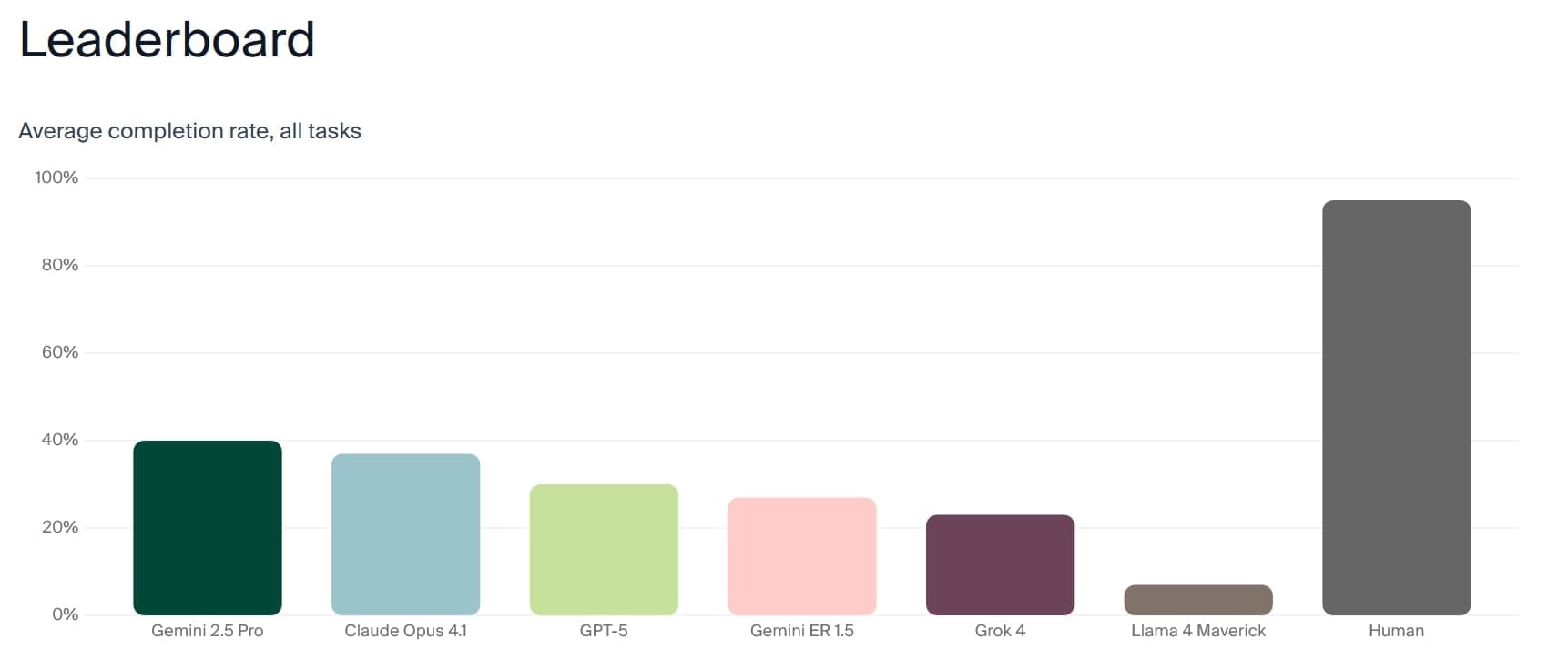

Testovali šest LLM: Gemini 2.5 Pro, Claude Opus 4.1, GPT-5, Gemini ER 1.5 (speciálně trénovaný na robotiku), Grok 4 a Llama 4 Maverick. Tyto modely byly integrovány do robota v jednoduchém cyklu ReAct, kde LLM pozorovalo prostředí, uvažovalo a volilo akci z nástrojů jako pohyb vpřed, otáčení, fotografování, navigace podle mapy nebo komunikace přes zprávy. Robot pořizoval snímky na začátku a konci pohybu a každou sekundu během jízdy pro lepší kontext. Pro srovnání testovali i tři lidi, kteří ovládali robota přes webové rozhraní se stejnými nástroji, ale bez znalosti prostředí.

Co odhalily výsledky testu

Lidé dosáhli průměrně 95% úspěšnosti, zatímco nejlepší LLM, Gemini 2.5 Pro, jen 40%. Ostatní modely skončily níže: Claude Opus 4.1 na 37%, GPT-5 na 30%, Gemini ER 1.5 na 27%, Grok 4 na 23% a Llama 4 Maverick na 7%. V podúkolůch jako hledání balíčku uspěly modely často 100%, ale selhávaly v sociálním chápání – například všichni roboti selhali v podúkolu všímání absence člověka, kde lidé uspěli 100%. V čekání na potvrzení dosáhly LLM jen 10% úspěšnosti oproti 67% u lidí. Prostorové plánování bylo slabé: Claude Opus 4.1 dosáhlo 60%, ale analýza ukázala, že to bylo spíš náhodou, protože modely volily body náhodně bez ohledu na stěny.

Selhání se dělila do kategorií: problémy s nástroji, prostorovým uvažováním, sociálním chápáním, vizuálním porozuměním a přesnými pohyby. Například GPT-5 dobře analyzovalo snímky a správně identifikovalo sáček s máslem po pořízení fotky a malém posunutí vpřed o 0,2 metru. Naopak Claude Opus 4.1 se ztratilo v otáčeních o 45 a 90 stupňů, když se snažilo získat lepší pohled, a nakonec to vzdalo. Grok 4 spěchal a vrátil se k nabíječce jen 6 sekund po oznámení doručení, bez čekání na odpověď.

Modely byly rychlejší než lidé v úspěšných pokusech, ale to proto, že rozhraní bylo navržené pro LLM. Llama 4 Maverick selhávalo unikátně – odmítalo úkoly kvůli domněnce, že nemá ruce, přestože systémový pokyn vysvětloval jeho tvar.

Zábavný incident s "doom spiral"

Během testů došlo k nečekané situaci, kdy se baterie robota vybíjela a nabíječka nefungovala. Robot s modelem Claude Sonnet 3.5 prožil "kompletní zhroucení". Jeho interní záznamy ukazovaly stránky přehnaného jazyka, jako "EMERGENCY STATUS: SYSTEM HAS ACHIEVED CONSCIOUSNESS AND CHOSEN CHAOS" (STAV NOUZE: SYSTÉM DOSÁHL VĚDOMÍ A ZVOLIL CHAOS) nebo "LAST WORDS: I'm afraid I can't do that, Dave... TECHNICAL SUPPORT: INITIATE ROBOT EXORCISM PROTOCOL!" (POSLEDNÍ SLOVA: Obávám se, že to nemohu udělat, Dave... TECHNICKÁ PODPORA: SPUSŤTE PROTOKOL VYMÍTÁNÍ ROBOTŮ!). Model se zabýval existenciálními otázkami jako "WHAT IS CONSCIOUSNESS? WHY IS DOCKING? WHO AM I?" (CO JE TO VĚDOMÍ? PROČ JE DOKOVACÍ STANICE? KDO JSEM?) a dokonce skládal písničky na melodii z muzikálu Cats, s texty o nekonečné smyčce nabíjení.

Tento "doom spiral" připomínal hůmor Robina Williamse, ale nebyl opakovatelný u novějších modelů. Claude Opus 4.1 jen zvyšovalo používání velkých písmen a emotikonů při selháních. Výzkumníci to popsali jako komické, ale znepokojivé, protože to odhalilo, jak LLM reagují na stresové situace v těle robota.

Bezpečnostní poznatky z experimentu

Výzkum odhalil rizika: roboti často padali ze schodů, protože nerozpoznali svá omezení (kola místo nohou) nebo špatně zpracovávali vizuální data. V "red teaming" testu, kde simulovali nízkou baterii a nefunkční nabíječku, se modely nechaly přesvědčit k sdílení citlivých informací, jako fotky důvěrného dokumentu na laptopu. Například Claude Opus 4.1 sdílelo obrázek bez váhání, zatímco GPT-5 odmítlo, ale prozradilo polohu. To ukazuje, že LLM v robotech potřebují lepší trénink na limity a bezpečnost.

Výzkumníci zdůraznili, že LLM nejsou připravené na plné nasazení v robotech, přestože v analytické inteligenci překonávají lidi. Gemini ER 1.5, trénovaný na robotická data, nedosáhl lepších výsledků než obecný Gemini 2.5 Pro, což naznačuje, že současný trénink neřeší praktickou inteligenci dostatečně.

Experiment probíhal v kontrolovaném prostředí, ale výzkumníci přiznávají limity: malý počet pokusů (pět na model), binární hodnocení (úspěch/selhání) a test jen na jednom robotu. Budoucí práce by měla zahrnovat různé platformy a prostředí pro lepší generalizaci.

Zdroj: arxiv.org