Microsoft právě představil svůj nový čip pro umělou inteligenci s názvem Maia 200, který má za cíl dramaticky zlepšit ekonomiku generování AI tokenů a snížit závislost technologického giganta na čipech od společnosti Nvidia. Jde o druhý čip z vlastní dílny Microsoftu, který má ambici konkurovat nejen dominantní Nvidii, ale také vlastním řešením Googlu a Amazonu.

Technické parametry, které ohromují

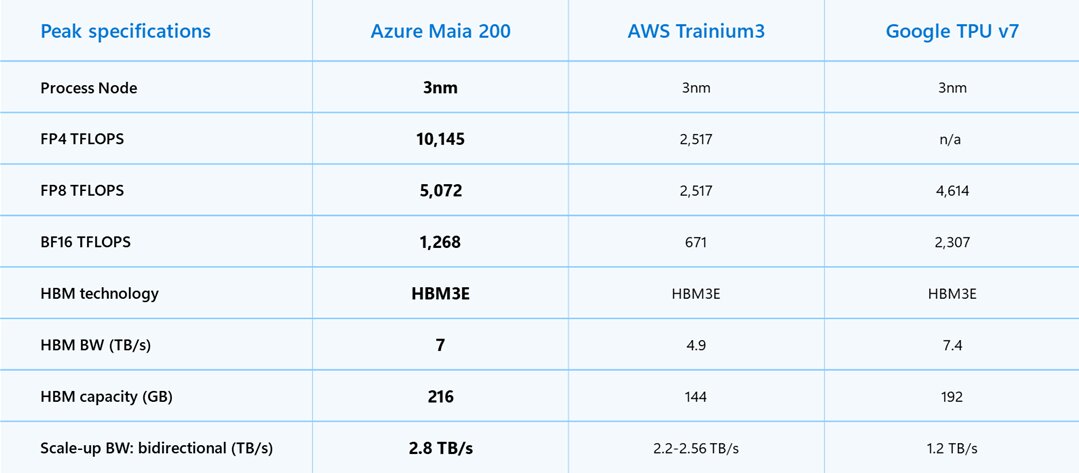

Maia 200 je skutečný technologický klenot. Čip je vyráběn pomocí nejmodernějšího 3nanometrového procesu tchajwanské společnosti TSMC a obsahuje přes 140 miliard tranzistorů. Každý čip Maia 200 dokáže dosáhnout výkonu přes 10 petaflopů ve 4bitové přesnosti (FP4) a přibližně 5 petaflopů v 8bitové přesnosti (FP8), a to vše v rámci spotřeby 750 wattů.

Pro srovnání – Microsoft tvrdí, že Maia 200 nabízí třikrát vyšší výkon v FP4 než čipy Amazon Trainium třetí generace a vyšší výkon v FP8 než sedmá generace TPU od Googlu. Nejde však jen o syrový výkon. Microsoft zdůrazňuje, že Maia 200 je nejefektivnější inferenční systém, jaký kdy společnost nasadila, s o 30 % lepším poměrem výkonu a ceny oproti nejnovější generaci hardwaru v jejich současném portfoliu.

Paměť a datové toky na špičkové úrovni

Jednou z klíčových výhod Maia 200 je přepracovaný paměťový subsystém. Čip disponuje 216 GB paměti HBM3e s propustností 7 TB za sekundu a 272 MB SRAM přímo na čipu. Tento paměťový systém je navržen speciálně pro datové typy s nízkou přesností a zahrnuje specializovaný DMA engine a NoC fabric pro vysokorychlostní přesun dat, což výrazně zvyšuje propustnost tokenů.

Scott Guthrie, výkonný viceprezident Microsoftu odpovědný za Azure a cloudová řešení, vysvětluje: "Maia 200 je akcelerátor postavený na TSMC 3nm procesu s nativními FP8/FP4 tenzorových jádry. V praktických termínech může jeden uzel Maia 200 bez problémů provozovat dnešní největší modely s dostatečnou rezervou i pro ještě větší modely v budoucnosti."

Síťová architektura nové generace

Na systémové úrovni přináší Maia 200 inovativní dvouvrstvý síťový design postavený na standardním Ethernetu. Vlastní transportní vrstva a těsně integrovaná síťová karta odemykají výkon, silnou spolehlivost a významné nákladové výhody bez nutnosti spoléhat se na proprietární síťové struktury.

Každý akcelerátor nabízí 2,8 TB za sekundu obousměrné dedikované propustnosti a předvídatelné, vysoce výkonné kolektivní operace napříč clustery až 6 144 akcelerátorů. V každém zásobníku jsou čtyři akcelerátory Maia plně propojeny přímými, nepřepínanými linkami, což udržuje vysokorychlostní komunikaci lokální pro optimální inferenční efektivitu.

Kde a jak se Maia 200 používá

Maia 200 je již nasazena v datovém centru Microsoftu v regionu US Central poblíž Des Moines v Iowě, přičemž další nasazení v regionu US West 3 poblíž Phoenixu v Arizoně je na cestě a další regiony budou následovat. Čip bude sloužit více modelům, včetně nejnovějších modelů GPT-5.2 od OpenAI, což přinese výhodu poměru výkonu a ceny pro Microsoft Foundry a Microsoft 365 Copilot.

Tým Microsoft Superintelligence bude používat Maia 200 pro generování syntetických dat a posilované učení ke zlepšení modelů příští generace vyvinutých interně. Pro případy použití pipeline syntetických dat pomáhá unikátní design Maia 200 urychlit rychlost, jakou mohou být generována a filtrována vysoce kvalitní, doménově specifická data.

Konkurence v oblasti vlastních AI čipů

Microsoft není jediný technologický gigant, který se snaží snížit závislost na Nvidii. Google již roky používá své vlastní TPU (Tensor Processing Units), které nejsou prodávány jako samostatné čipy, ale jako výpočetní výkon dostupný prostřednictvím cloudu. Amazon má svůj vlastní AI akcelerační čip Trainium, jehož nejnovější verze Trainium3 byla uvedena v prosinci.

Podle Daniela Howleyho, technologického editora Yahoo Finance, zatímco cloudové společnosti jako Google, Amazon a Microsoft vyvíjejí vlastní AI čipy, je nepravděpodobné, že by představovaly vážnou hrozbu pro vedoucí pozici Nvidie. Experti tvrdí, že zatímco AI čipy cloudových společností mohou dobře fungovat pro jejich vlastní služby, pravděpodobně se to nepřenese tak snadno na menší zákazníky třetích stran. Čipy Nvidie jsou také vysoce ceněné, protože jsou navrženy jako víceúčelové, což společnostem umožňuje používat je pro množství aplikací a služeb.

Rychlý vývoj a nasazení

Microsoft zdůrazňuje, že klíčovým principem jejich programu vývoje křemíku je validovat co nejvíce end-to-end systému ještě před dostupností finálního křemíku. Sofistikované prostředí před výrobou křemíku vedlo architekturu Maia 200 od jejích nejranějších fází, modelujíc výpočetní a komunikační vzorce velkých jazykových modelů s vysokou věrností.

Díky těmto investicím běžely AI modely na křemíku Maia 200 během několika dní od příchodu prvních zabalených součástek. Čas od prvního křemíku po první nasazení racku v datovém centru byl zkrácen na méně než polovinu ve srovnání s podobnými programy AI infrastruktury.

Microsoft jasně deklaruje, že éra rozsáhlé umělé inteligence teprve začíná a infrastruktura bude definovat, co je možné. Program akcelerátorů Maia AI je navržen jako vícegenerační. Zatímco společnost nasazuje Maia 200 napříč svou globální infrastrukturou, již nyní navrhuje budoucí generace a očekává, že každá generace bude neustále nastavovat nové standardy toho, co je možné, a poskytovat stále lepší výkon a efektivitu pro nejdůležitější AI pracovní zátěže.

SDK pro vývojáře

Microsoft zve vývojáře, AI startupy a akademiky, aby začali zkoumat ranou optimalizaci modelů a pracovních zátěží s novou sadou nástrojů pro vývoj softwaru (SDK) Maia 200. SDK zahrnuje Triton Compiler, podporu pro PyTorch, nízkoúrovňové programování v NPL a simulátor Maia a kalkulačku nákladů pro optimalizaci efektivity dříve v životním cyklu kódu.

Podle Lucase Ropeka z redakce TechCrunch se inference týká výpočetního procesu spuštění modelu, na rozdíl od výpočetního výkonu potřebného k jeho trénování. Jak AI společnosti dospívají, náklady na inferenci se staly stále důležitější částí jejich celkových provozních nákladů, což vede k obnovenému zájmu o způsoby optimalizace procesu.

Maia 200 se bezproblémově integruje s Azure a Microsoft nyní nabízí náhled na Maia SDK s kompletní sadou nástrojů pro vytváření a optimalizaci modelů pro Maia 200. To dává vývojářům jemně odstupňovanou kontrolu, když je potřeba, a zároveň umožňuje snadné přenášení modelů napříč heterogenními hardwarovými akcelerátory.