Meta představuje revoluční technologii pro přirozenou komunikaci s avatary

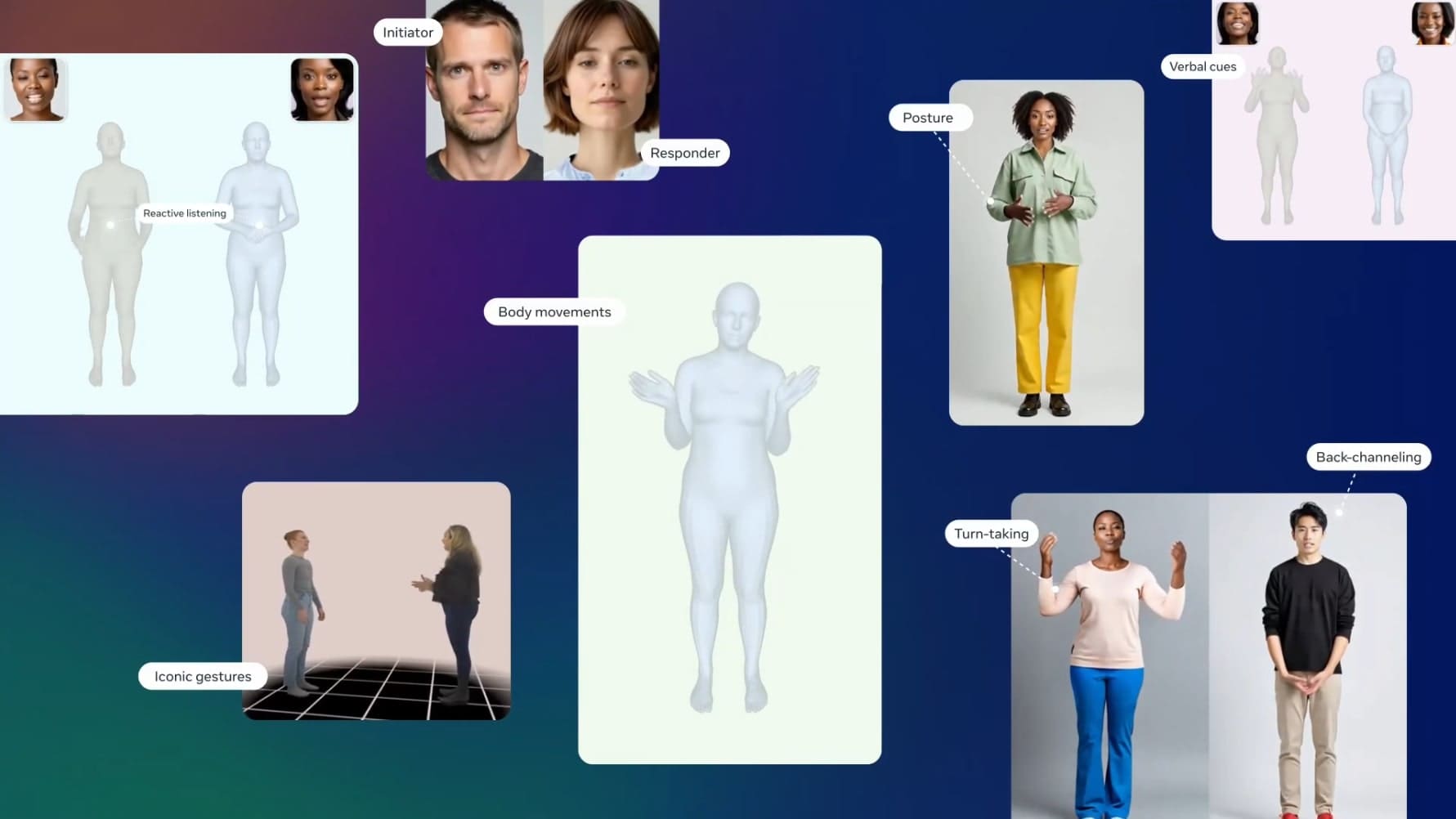

Komunikace mezi lidmi je jako tanec, kde každá osoba neustále upravuje to, co říká, jak to říká a jak gestikuluje. Modelování dvoumístné nebo dyadické konverzační dynamiky zahrnuje pochopení multimodálního vztahu mezi hlasovými, verbálními a vizuálními sociálními signály – a interpersonálního chování mezi lidmi, jako je naslouchání, vizuální synchronie a střídání v řeči.

Představení rodiny Dyadic Motion Models

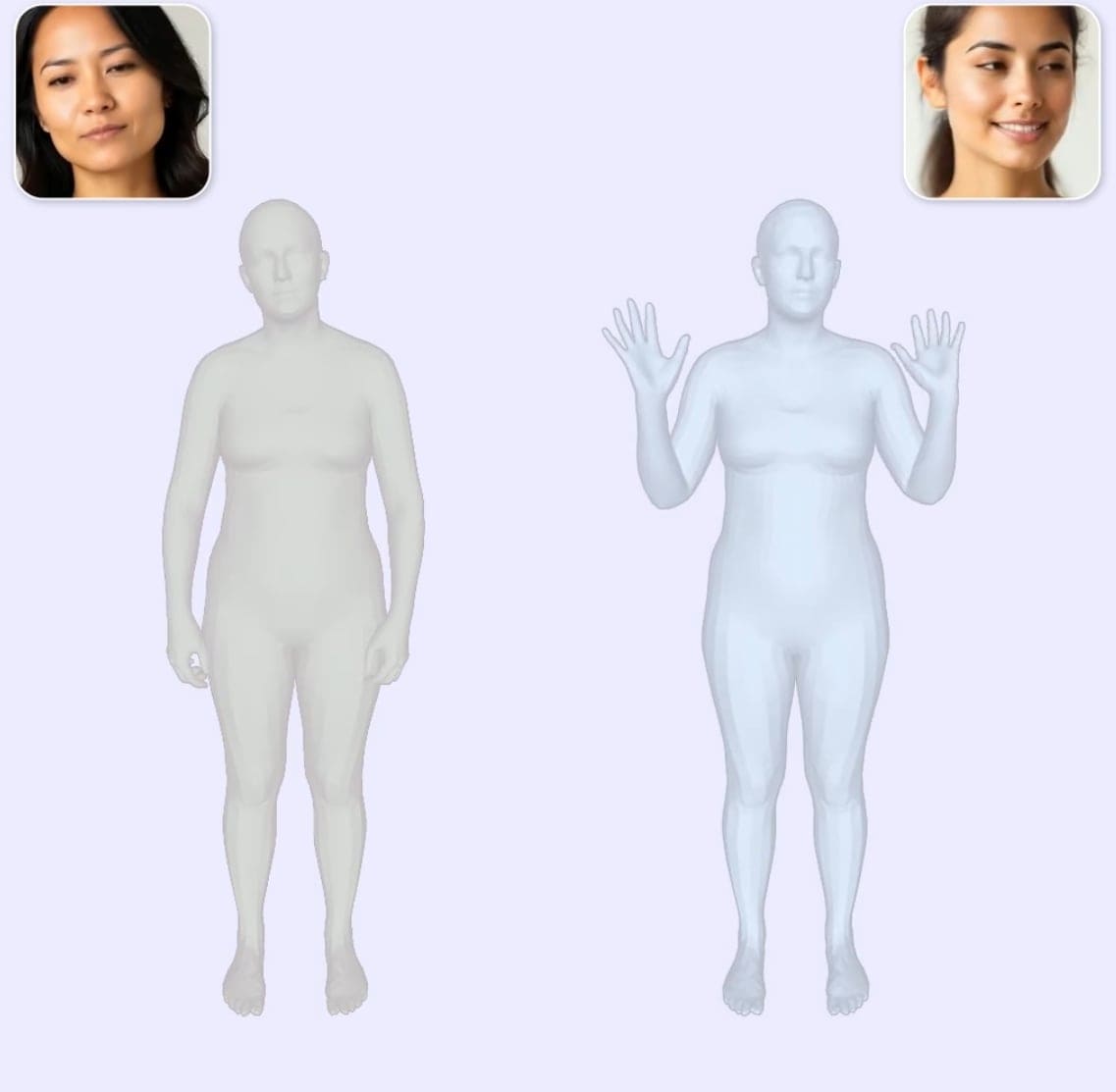

Meta Fundamental AI Research (FAIR) ve spolupráci s laboratořemi Codec Avatars a Core AI představuje rodinu Dyadic Motion Models, které zkoumají nové hranice sociální umělé inteligence. Tyto modely umí převést lidskou řeč nebo řeč generovanou jazykovými modely mezi dvěma osobami na rozmanité, expresivní gesta celého těla a chování aktivního naslouchání.

Modely zpracovávají zvukové a vizuální vstupy, aby zachytily detaily konverzační dynamiky s potenciálem vytvořit přirozenější a interaktivnější virtuální agenty, kteří se mohou zapojit do lidských sociálních interakcí v různých imerzivních prostředích.

Audio-Visual Dyadic Motion modely v akci

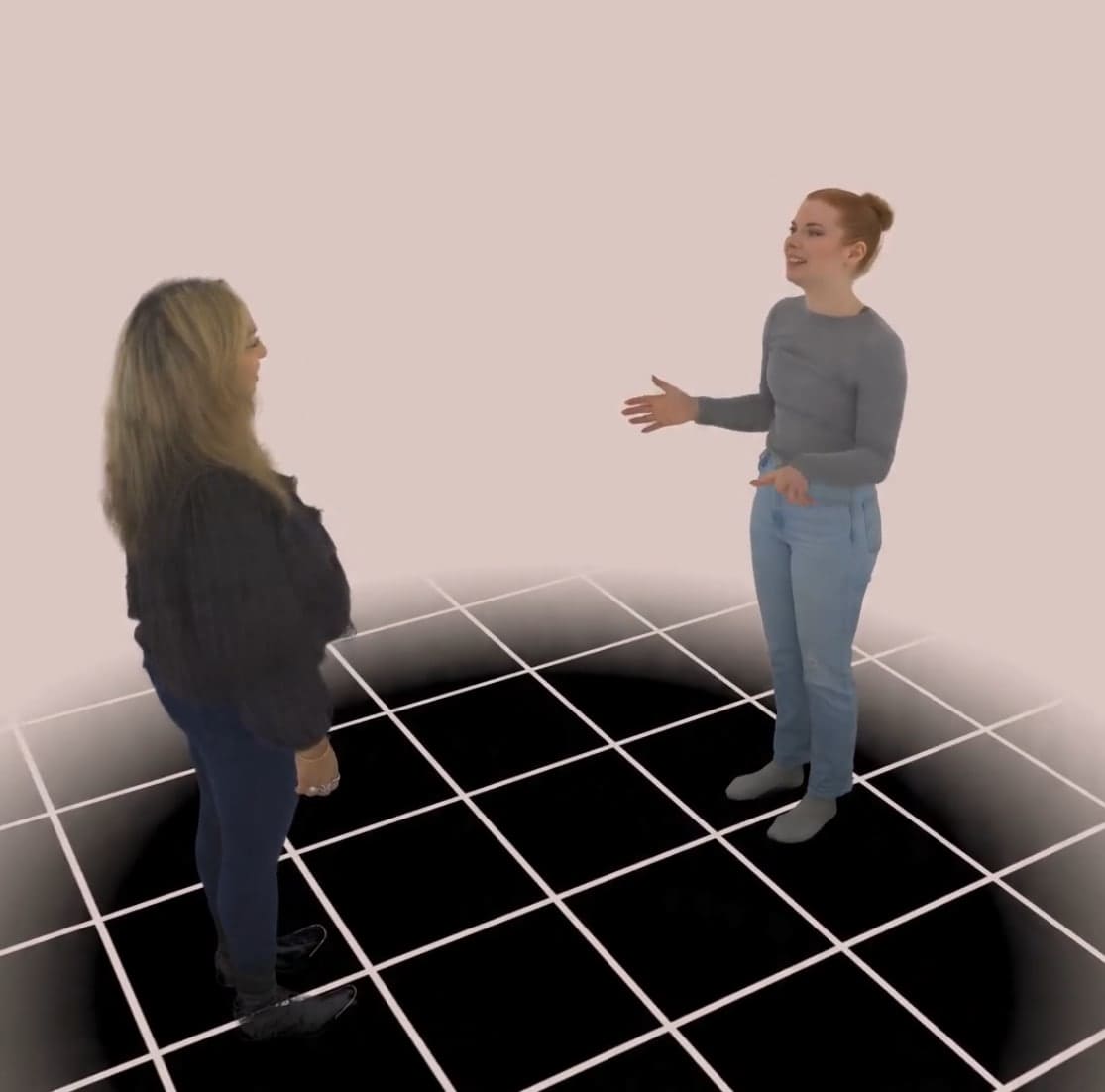

Audio-Visual (AV) Dyadic Motion modely dokážou společně generovat výrazy obličeje a gesta těla. Modely používají jako vstup zvuk, buď od dvou lidí nebo výstup z velkých jazykových modelů (LLM), aby vytvořily behaviorální komponentu. Představte si vizualizaci dříve nahraného podcastu mezi dvěma mluvčími – generování celého spektra emocí, gest a pohybů vyplývajících z jejich řeči.

AV Dyadic Motion modely produkují gesta a výrazy jednoho konkrétního mluvčího, přičemž berou v úvahu zvuk od obou lidí. To umožňuje modelům vizualizovat řečová gesta, gesta naslouchání a signály pro střídání v řeči. Modely jdou ještě o krok dále tím, že také berou v úvahu vizuální vstup druhé strany. To umožňuje modelům naučit se vizuální synchronizační signály, jako je zrcadlení úsměvu nebo společná pozornost pohledu.

Seamless Interaction Dataset – nevídaný rozsah dat

Seamless Interaction Dataset je největší známý video dataset osobních, dvoumístných konverzačních interakcí a je zásadní k pochopení a modelování toho, jak lidé komunikují a chovají se, když jsou spolu. Dataset zahrnuje:

- Více než 4 000 hodin audiovizuálního behaviorálního materiálu s více než 4 000 účastníky

- Přibližně 1 300 konverzačních a aktivitních podnětů s naturalistickým a improvizovaným obsahem

- Bohatou kontextualizaci s metadaty na úrovni vztahů účastníků a osobnosti, spolu s téměř 5 000 video anotacemi

Všechny konverzace byly zaznamenány s účastníky na stejném místě, aby se zachovaly základní charakteristiky vtělené interakce a vyhnuly se nevýhodám vzdálené komunikace založené na videu. Z těchto nahrávek je jedna třetina interakcí mezi dvěma lidmi, kteří se navzájem znají, jako jsou členové rodiny, přátelé nebo kolegové.

Využití profesionálních herců pro diverzitu emocí

Bylo důležité, aby dataset zachytil širokou škálu lidských emocí a postojů, jako je překvapení, nesouhlas, odhodlání a lítost – jinými slovy, různorodost lidského chování tváří v tvář. Tyto typy interakcí je obtížné zachytit v naturalistických datech, takže tým najal profesionální herce se zkušenostmi s improvizací, aby ztvárnili řadu rolí a emocí. Tyto konverzace tvoří přibližně jednu třetinu datasetu.

Pokročilé funkce modelů

Modely byly navrženy tak, aby vydávaly mezikódy pro pohyb obličeje a těla, což odemyká širokou škálu možností pro jejich aplikaci. Tento přístup umožňuje adaptovat tyto modely pro použití v různých kontextech, včetně generování 2D videa a animace 3D Codec Avatars, které lze použít v imerzivních VR a AR zážitcích.

Výzkumníci navíc vyvinuli tyto modely začleněním dalších parametrů kontroly, což poskytuje větší flexibilitu a kontrolu nad chováním modelů. To může být obzvláště užitečné, když uživatelé nebo designéři chtějí upravit expresivitu avatara při mluvení nebo naslouchání.

Bezpečnostní opatření a ochrana soukromí

Meta prioritizuje soukromí, etiku a kvalitu při sběru a zpracování dat pro svůj výzkum. Během vytváření datasetu účastníci souhlasili se sběrem svých nahraných konverzací a byli upozorněni, aby se vyhnuli sdílení osobně identifikovatelných informací.

Byl implementován vícestupňový proces zajištění kvality:

- Lidské recenze: Lidští recenzenti hodnotili video obsah na známky citlivého materiálu

- Analýza textových přepisů pomocí LLM: Písemné přepisy byly analyzovány za účelem detekce citlivého materiálu

- Analýza videa pomocí Video Language modelů: Video Language modely byly použity k detekci citlivého materiálu

Watermarking technologie pro autenticitu

Meta používá AudioSeal a VideoSeal k označování obsahu vodoznaky, který je generován z jejich audiovizuálních behaviorálních modelů. Tyto modely umožňují vkládat tajné zprávy do jednotlivých snímků původního obsahu, které pak mohou být extrahovány detektory. To umožňuje ověřit autenticitu a původ obsahu i po zpracování nebo manipulaci.

Budoucnost sociálních technologií

Výzkumné modely mají potenciál transformovat budoucí sociální technologie, které pomáhají zlepšit náš každodenní život, bavit nás a přiblížit nás k sobě. Prioritizováním odpovědných praktik umělé inteligence Meta doufá, že bude nadále budovat důvěru ve své modely a vytvářet technologie, které prospívají všem.

Dataset a technická zpráva, kterou tým sdílí, mohou sloužit jako plán pro budoucí výzkum audiovizuálního behaviorálního modelování interakcí. Tyto modelovací schopnosti postavené na datasetu pomohou transformovat sociální virtuální agenty, technologie telepresence v prostředí VR a AR a multimodální analýzu video obsahu.