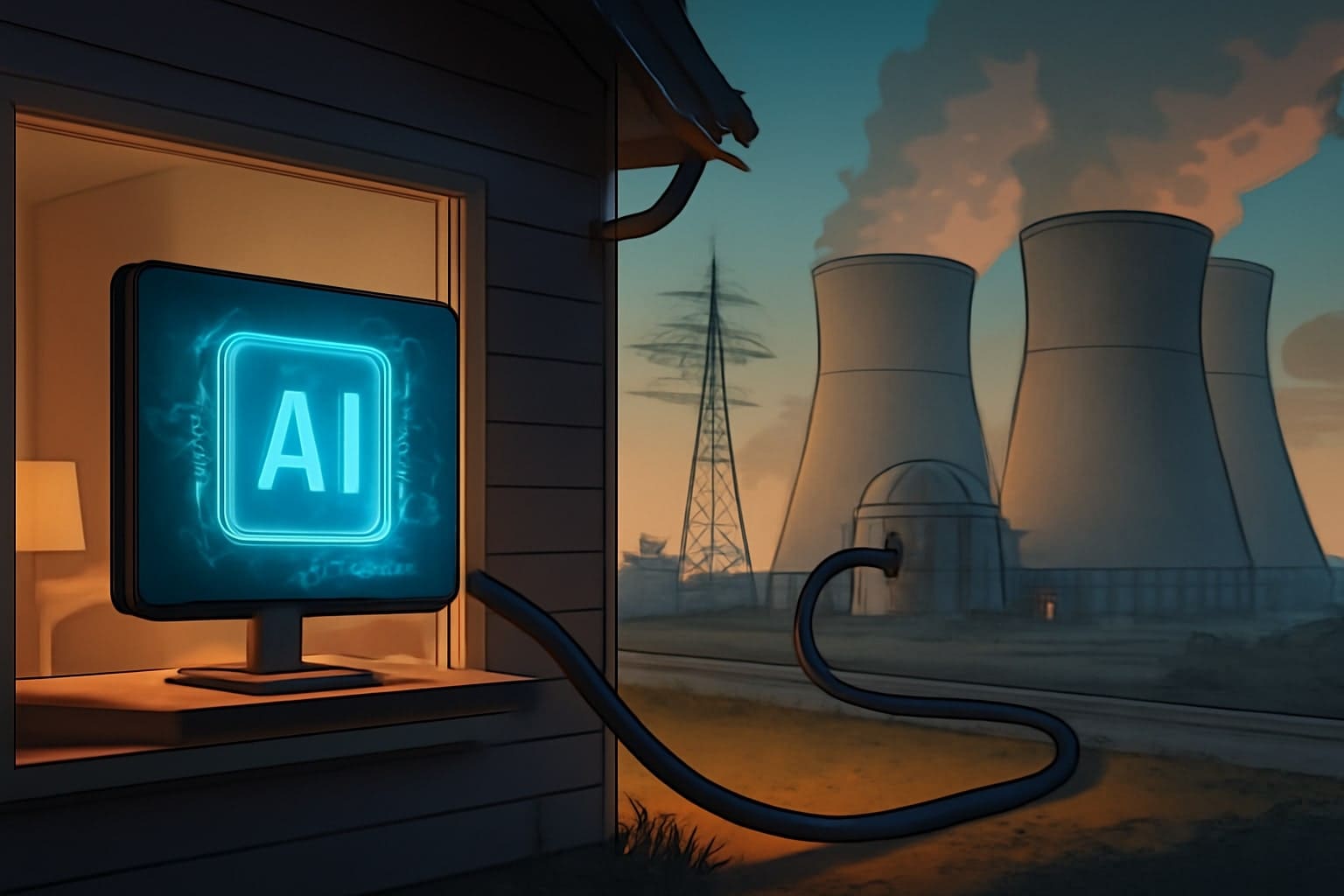

Kolik energie opravdu spotřebovává umělá inteligence?

Umělá inteligence se stala součástí našeho každodenního života, od jednoduchých dotazů v chatech až po složité analýzy. Ale za každou odpovědí se skrývá otázka, která trápí odborníky: kolik energie to všechno stojí? Podle Sama Altmana, generálního ředitele společnosti OpenAI, spotřebuje průměrný dotaz v ChatGPT asi 0,34 watt-hodiny energie. To je zhruba tolik, kolik by trouba spotřebovala za něco málo přes sekundu nebo úsporná žárovka za pár minut. S 800 miliony týdenních aktivních uživatelů to ale znamená obrovskou kumulativní spotřebu, která roste rychleji, než si mnozí uvědomují.

Tento údaj však vyvolává pochybnosti. Sasha Luccioni, vedoucí klimatického týmu ve společnosti Hugging Face, ho označuje za nedůvěryhodný, protože OpenAI neposkytuje podrobnosti o tom, jak k němu došli. Co přesně znamená "průměrný dotaz"? Zahrnuje to generování obrázků? A co energie na trénink modelů nebo chlazení serverů? Bez těchto informací je těžké číslo brát vážně. Výzkum z roku 2025 ukazuje, že datová centra, kde AI běží, mohou do roku 2030–2035 spotřebovávat až 20 % globální elektřiny, přičemž v USA už v roce 2023 zabírala 4,4 % národní spotřeby a do roku 2028 by se to mohlo ztrojnásobit.

Proč firmy mlčí?

Velké společnosti jako OpenAI a Anthropic drží své modely proprietární, což znamená, že externí výzkumníci nemohou ověřit jejich energetickou spotřebu. Analýza od Sashy Luccioni a jejích kolegů, předložená k recenzi v roce 2025, ukazuje, že v květnu 2025 tvořilo 84 % provozu velkých jazykových modelů (LLM) ty, které nemají žádné informace o environmentálním dopadu. Uživatelé tak volí nástroje s neznámou uhlíkovou stopou, což je alarmující v době klimatické krize.

Luccioni to přirovnává k nákupu auta: víte, kolik spotřebuje na 100 km, ale u AI žádné takové metriky neexistují. Místo toho se šíří neověřené odhady, jako ten od Johna Hennessyho, předsedy Alphabetu (mateřské společnosti Google), který v roce 2023 řekl, že dotaz v ChatGPT spotřebuje 10krát více energie než vyhledávání na Googlu. Tento údaj se opakuje v médiích a politických zprávách, přestože pochází z neověřeného zdroje. Výzkum z roku 2025 potvrzuje, že složité dotazy mohou produkovat až 50krát více CO₂ emisí než jednoduché, a přesnější modely jsou energeticky náročnější.

Co nám říkají data?

Abychom se dostali k reálnějším číslům, obracejí se vědci k otevřeným modelům, kde lze spotřebu měřit. Studie publikovaná v časopise Frontiers of Communication v roce 2025 zkoumala 14 otevřených velkých jazykových modelů, včetně dvou modelů Meta Llama a tří DeepSeek. Výsledky ukázaly, že některé modely spotřebovávají až o 50 % více energie než jiné při odpovídání na stejné dotazy. Výzkumníci odeslali 1000 benchmarkových otázek z oblastí jako středoškolská historie nebo filozofie – polovina byla ve formě vícenásobné volby s jednoslovnými odpověďmi, polovina otevřená pro delší reakce.

Modely zaměřené na složité uvažování generovaly více "myšlenkových tokenů" – interních kroků při zpracování odpovědi – což zvyšuje spotřebu. Tyto modely byly přesnější u komplexních témat, ale měly problém s krátkostí: i při instrukcích vracely delší odpovědi. Hlavní autor studie, Maximilian Dauner, doktorand na Mnichovské univerzitě aplikovaných věd, navrhuje směrovat jednoduché dotazy k méně náročným modelům, které dosahují dobrých výsledků s nižšími emisemi. Společnosti jako Google a Microsoft už to dělají v některých vyhledávacích funkcích pro rychlejší a úspornější odpovědi.

Další faktory: Hardware, infrastruktura a reálný svět

Spotřeba energie není jen o samotném modelu – záleží na hardware a podmínkách. Studie Maximiliana Daunera běžela na GPU Nvidia A100, ale novější Nvidia H100, navržená pro AI, je ještě energeticky náročnější. Datová centra potřebují chlazení, osvětlení a síťové vybavení, což přidává další spotřebu. Tyto centra často fungují v denních cyklech, s nižší aktivitou v noci, a jsou napojena na různé sítě – někde na fosilní paliva, jinde na obnovitelné zdroje.

Noman Bashir, fellow pro výpočetní techniku a klimatický dopad na MIT, přirovnává studie bez zohlednění těchto faktorů k testu spotřeby auta bez zátěže. Navíc trénink modelů a jejich aktualizace žerou obrovské množství energie, které firmy jako OpenAI tají. Výzkum z roku 2025 ukazuje, že i když efektivní opatření jako AI-optimalizované chlazení (například Google DeepMind snížilo spotřebu o 30 %) nebo virtualizace serverů snižují náklady, celková spotřeba roste díky "rebound efektu" – větší efektivita vede k většímu používání.

Šance na snížení emisí?

Přestože AI zvyšuje emise, může je také snižovat. Nový výzkum z roku 2025 naznačuje, že pokud se AI efektivně aplikuje v sektorech jako energetika, doprava a potravinářství, mohla by do roku 2035 snížit globální emise o 3,2 až 5,4 miliardy tun CO₂ ekvivalentu ročně. To by převážilo nad její vlastní spotřebou. V energetice AI zlepšuje efektivitu obnovitelných zdrojů a správu sítí, s úsporami 10–60 % v některých případech.

Sasha Luccioni volá po povinném hlášení uhlíkových čísel pro všechny AI systémy. Bez průhlednosti zůstáváme v temnotě o skutečném dopadu této technologie na planetu. Je na čase, aby firmy otevřely své knihy a pomohly nám pochopit, jestli AI bude žroutem nebo záchrancem naší planety.