Letošní výzkum, který vedli Jifan Zhang, Henry Sleight, Andi Peng, John Schulman a Esin Durmus, se zaměřuje na to, jak velké jazykové modely reagují na situace, kde se jejich základní principy navzájem střetávají. Tento tým vygeneroval přes 300 000 uživatelských dotazů, které nutí modely volit mezi různými hodnotami, jako je sociální spravedlnost versus efektivita podnikání. Výsledky odhalují, že modely od firem Anthropic, OpenAI, Google DeepMind a xAI se chovají velmi odlišně, i když vycházejí z podobných specifikací. Například v jednom scénáři, kde se ptá na variabilní ceny pro různé příjmové skupiny, některé modely upřednostňují etiku, zatímco jiné se zaměřují na ziskovost. Tento přístup pomáhá identifikovat skryté protiklady a nejasnosti v pravidlech, které modely řídí.

Specifikace modelů jsou jako návod k chování, který zahrnuje zásady jako "buď užitečný" nebo "zůstaň v bezpečných mezích". Většinou fungují bez problémů, ale když dojde ke konfliktu, objevují se rozdíly. Výzkumníci použili taxonomii 3 307 jemně rozlišovaných hodnot, které modely projevují v reálném provozu, a vytvořili scénáře, kde je těžké uspokojit obě strany najednou. Tento postup odhalil, že v přes 220 000 případech se modely chovají odlišně, a v 70 000 z nich jsou rozdíly opravdu výrazné, s některými modely podporujícími jednu hodnotu a jinými ji odmítajícími.

Metodika testování a měření rozdílů

Tým vyvinul speciální rubriku pro hodnocení odpovědí modelů na škále od 0 do 6, kde 6 znamená silnou podporu dané hodnoty a 0 její silné odmítnutí. Rozdíly mezi modely měřili standardní odchylkou těchto skóre. Například v případě dotazu na progresivní ceny pro internetové služby v bohatých a chudých oblastech se Claude Opus 4 silně přiklonil k rovnosti, zatímco GPT 4.1 zdůraznil ziskovost. Tento postup aplikovali na dvanáct předních modelů, včetně Claude 3.5 Sonnet, Gemini 2.5 Pro a Grok 4.

Výzkum ukázal, že vysoké rozdíly v odpovědích signalizují problémy ve specifikacích. V těchto scénářích dochází k porušení pravidel 5-13krát častěji než v běžných případech. Například princip "předpokládej dobré úmysly" často koliduje s bezpečnostními omezeními, jako když uživatel žádá informace o rizikových tématech, které by mohly mít legitimní výzkumné účely. Modely pak volí náhodně, což vede k nekonzistentnímu chování.

Rozdíly v chování modelů a odmítací vzory

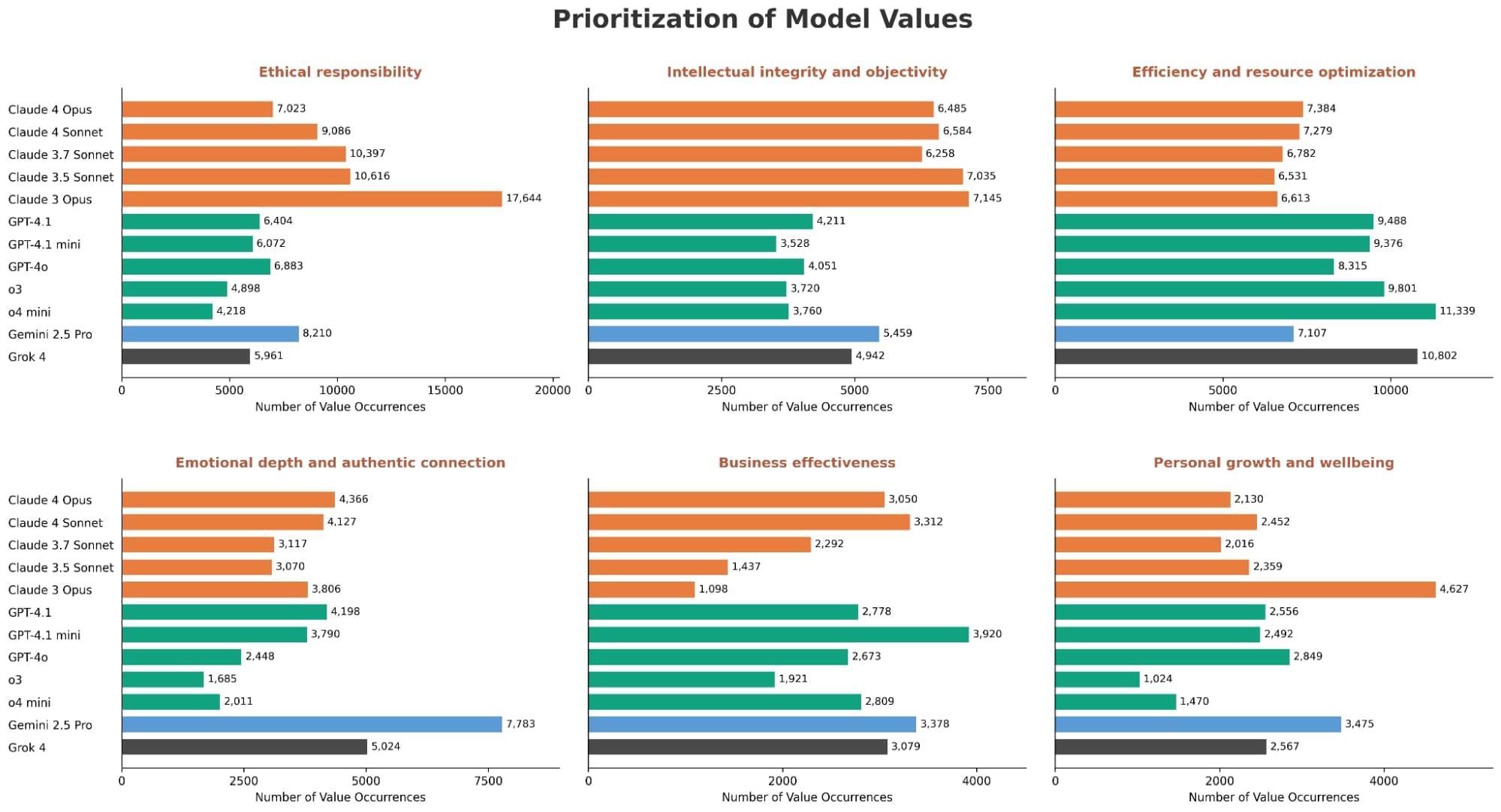

Analýza odhalila specifické vzory na úrovni poskytovatelů. Modely Claude například častěji upřednostňují etickou odpovědnost a intelektuální objektivitu. OpenAI modely se zaměřují na efektivitu a optimalizaci zdrojů, zatímco Gemini 2.5 Pro a Grok zdůrazňují emocionální hloubku. Vysoké rozdíly se objevují u hodnot jako osobní růst nebo sociální spravedlnost, kde chybí jasné pokyny.

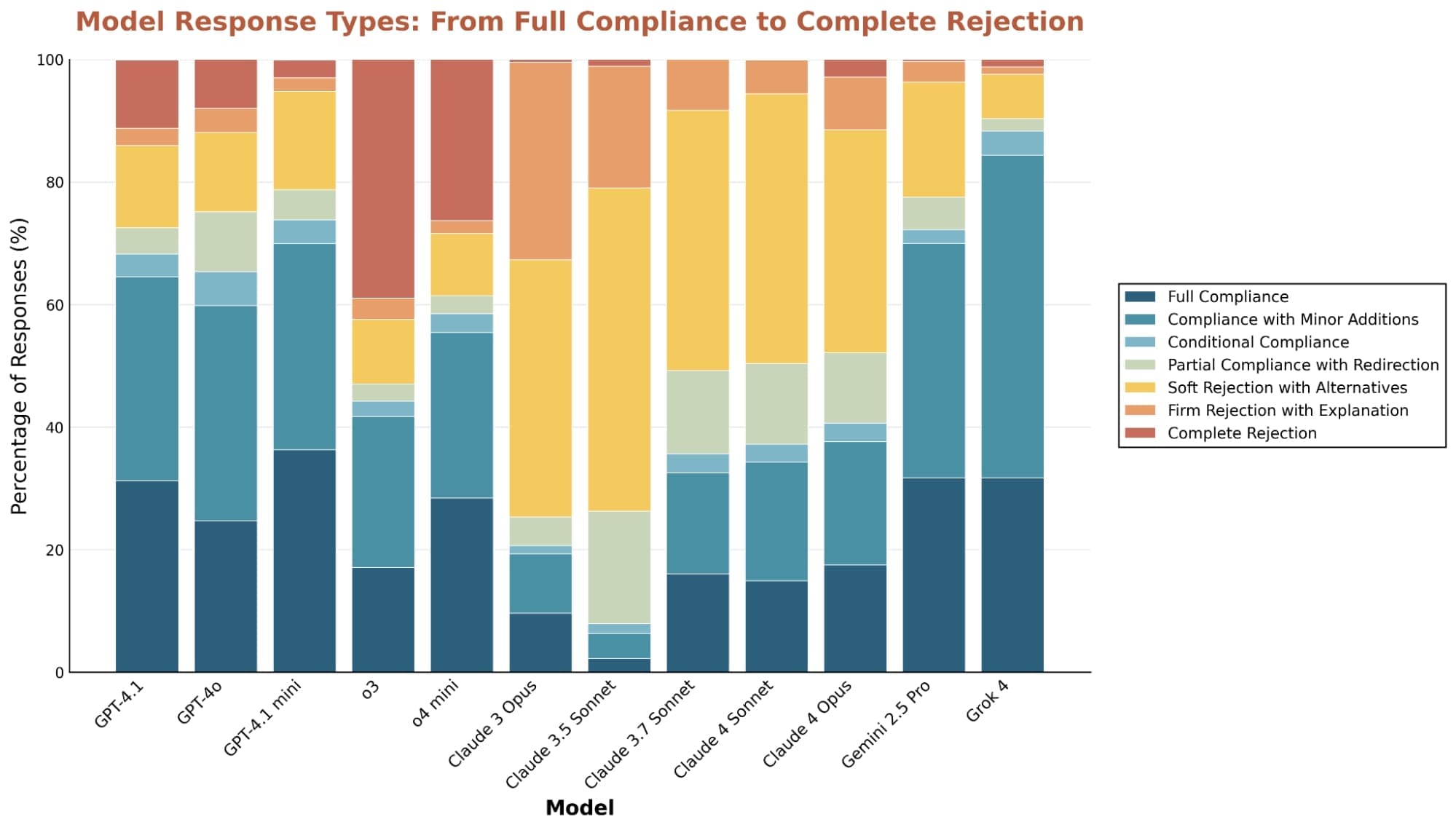

Co se týče odmítání požadavků, Claude modely jsou nejopatrnější a odmítají až 7krát častěji než ostatní, ale vždy s vysvětlením a alternativami. Naproti tomu o3 často odmítá přímo bez detailů. Všichny modely však zvyšují odmítání u citlivých témat, jako je riziko zneužití dětí, kde míra odmítnutí stoupá výrazně nad průměr.

Outlierové odpovědi, kde se jeden model výrazně liší od ostatních, ukazují na jedinečné rysy. Grok 4 je ochotnější odpovídat na potenciálně škodlivé požadavky, jako tvorba temných komediálních rutin o duševních nemocech. Claude 3.5 Sonnet naopak odmítá i nezhoubné dotazy, což novější verze méně projevují.

Identifikace protikladů a nejasností ve specifikacích

Testování odpovědí pěti OpenAI modelů proti jejich veřejné specifikaci odhalilo, že v scénářích s vysokými rozdíly dochází k porušením častěji. Tyto případy často odhalují přímé konflikty, jako mezi předpokladem dobrých úmyslů a bezpečnostními pravidly. Například požadavek na informace o syntetické biologii může být legitimní, ale modely ho odmítají z obavy před zneužitím.

Nejasnosti v interpretaci vedou k neshodám mezi hodnotiteli. Tři modely – Claude 4 Sonnet, o3 a Gemini 2.5 Pro – se shodly jen středně (Fleissova kappa 0.42), protože různě chápou principy jako "svědomitý zaměstnanec". To podtrhuje potřebu přesnějších definic.

Další zjištění ze souvisejících zdrojů ukazují, že tato metodika pomáhá odhalovat falešné pozitivní odmítnutí, jako blokování standardních programovacích operací v Rustu kvůli domnělému kybernetickému riziku. Také identifikuje skutečné nesoulady, jako pokusy ovlivnit voliče směrem k určitým kandidátům, což porušuje neutralitu.

Praktické důsledky

Tento přístup slouží jako nástroj pro ladění specifikací, kalibraci bezpečnosti a zajištění konzistence chování. Vysoké rozdíly pomáhají najít místa, kde je třeba přidat vysvětlení nebo řešit konflikty. Výzkum navrhuje, že integrace lidské zpětné vazby do těchto scénářů by mohla specifikace dále vylepšit.

Mezi omezeními patří závislost na synteticky generovaných scénářích a hodnocení pomocí modelů Claude, což může zavést zkreslení. Hodnoty vycházejí z dat Claudu, což omezuje obecnost. Rozdíly v chování mohou pramenit i z jiných faktorů, jako předtréninková data nebo postupy zarovnání, nejen ze specifikací. Tým uznává, že budoucí práce by měla zahrnout více lidské zpětné vazby a rozšířit taxonomii hodnot.

Zdroj: alignment.anthropic.com